- 商湯資訊

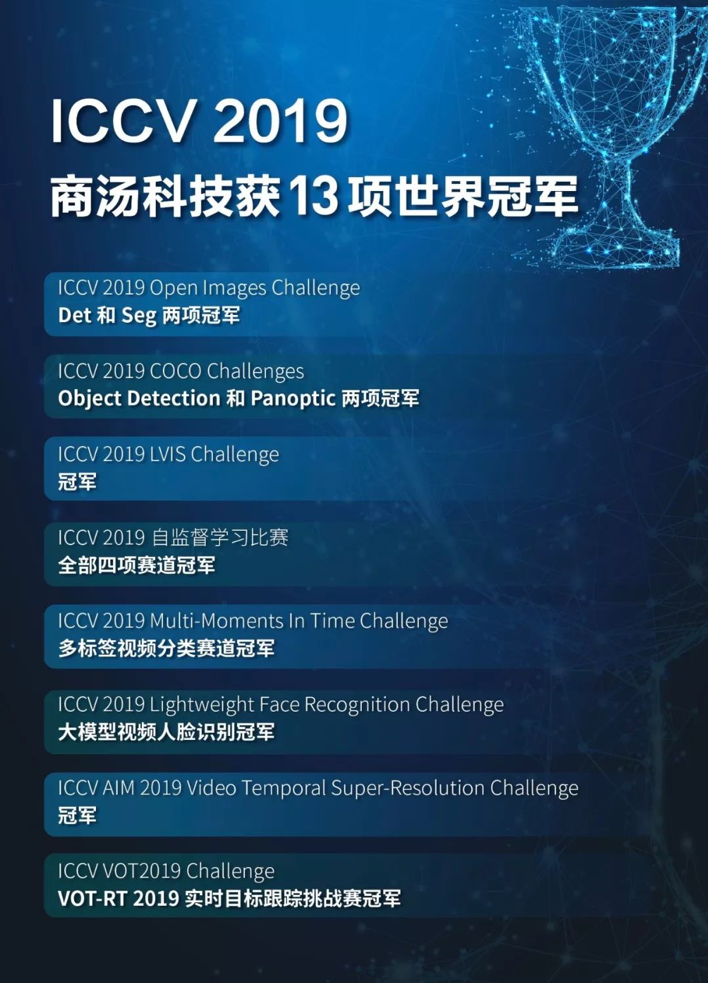

商湯科技57篇論文入選ICCV 2019,13項競賽奪冠

兩年一屆的ICCV 2019(International Conference on Computer Vision)於10月27日-11月2日在韓國首爾召開。今年的ICCV,商湯科技繼續在入選論文數量、質量以及諸多競賽項目中刷新紀錄,彰顯中國原創技術的領先性及深厚學術底蘊,引領計算機視覺學術發展。

商湯科技及聯合實驗室共有57篇論文入選ICCV 2019(包含11篇Oral),同時在Open Images、COCO、LVIS等13項重要競賽中奪冠。特別是Open Images,它是目前通用物體檢測和實例分割兩個領域中數據量最大,數據分佈最複雜,最有挑戰性的競賽,比COCO數據大一個量級,標注更不規則,場景更複雜。

除了成績,商湯科技在開放學術交流、生態發展方面也為全球學術領域做出積極貢獻,由商湯及聯合實驗室研究團隊去年發佈的開源物體檢測框架MMDetection,在今年各大比賽中被眾多參賽隊伍廣泛使用,Open Images,COCO,LVIS,Mapillary等比賽中的多支獲獎隊伍都使用MMDetection作為基準代碼庫,團隊去年提出的HTC,Guided Anchoring等方法成為了今年諸多隊伍的關鍵助力。

ICCV 2019期間,商湯科技還組織或參與主辦了多場Challenge和Workshop,香港中文大學-商湯聯合實驗室的周博磊教授參與組織了上千人的Tutorial——Interpretable Machine Learning for Computer Vision。此外,商湯科技聯合創始人、香港中文大學教授湯曉鷗受邀擔任ICCV 2019大會主席。

商湯科技創始人、香港中文大學教授湯曉鷗受邀擔任ICCV 2019大會主席

57篇論文入選ICCV 2019,13個項目奪冠

著名科幻小說家阿西莫夫說,「創新是科學房屋的生命力 」。擁有深厚學術底蘊的商湯科技,自成立以來始終以「堅持原創,讓AI引領人類進步 」為使命,在人工智能技術研究上不斷尋求自我突破和創新。此次,商湯科技及聯合實驗室共有57篇論文入選ICCV 2019,其中口頭報告(Oral)論文就有11篇。ICCV論文錄用率非常低,今年Oral錄用比例僅為4.62%。

商湯科技被ICCV 2019錄取的論文在多個領域實現突破,包括:面向目標檢測的深度網絡基礎算子、基於插值卷積的點雲處理主幹網絡、面向AR/VR場景的人體感知與生成、面向全場景理解的多模態分析等。這些突破性的計算機視覺算法有著豐富的應用場景,將為推動AI行業發展做出貢獻。

同時,商湯科技不僅在論文錄取數上展現出了驚人實力,在ICCV的諸多競賽項目上也屢屢奪冠,一舉斬獲13項世界冠軍。

在Google AI主辦的ICCV 2019 Open Images比賽中,來自香港中文大學和商湯研究院的聯合團隊奪得了物體檢測和實例分割兩個主要賽道的冠軍。此次主辦方提供了千萬級別的實例框,涵蓋了500類結構性類別,其中包含大量漏標、類別混淆和長尾分佈等問題。競賽中,得益於團隊提出的兩個全新技術:頭部空間解耦檢測器(Spatial Decoupling Head)和模型自動融合技術(Auto Ensemble)。前者可以令任意單模型在COCO和Open Images上提升3-4個點的mAP,後者相對于樸素模型融合能提升0.9mAP。最終,在提交次數顯著小於其他高名次隊伍下獲得了雙項冠軍的好成績。

在ICCV 2019 COCO比賽中,來自香港中文大學-商湯科技聯合實驗室和南洋理工大學S-Lab的MMDet團隊獲得目標檢測(Object Detection)冠軍(不使用外部數據集),這也是商湯連續兩屆在COCO Detection項目中奪冠。同時,商湯科技新加坡研究團隊也獲得COCO全景分割(Panoptic)冠軍(不使用外部數據集)。

COCO比賽中,MMDet團隊提出了兩種新的方法來提升算法性能。針對於當前目標框定位不夠精確的缺陷,MMDet團隊提出了一種解耦的邊緣感知的目標框定位算法(Decoupled Boundary-Aware Localization (DBAL)),該方法專注於物體邊緣的信息而非物體全域的信息,使用一種從粗略估計到精確定位的定位流程,在主流的物體檢測方法上取得了顯著的提升。

而商湯科技新加坡研究團隊深入探索了全景分割任務的獨特性質,並提出了多項創新算法。由於全景分割任務既涵蓋目標檢測又包含語義分割,往屆比賽隊伍大多分別提升目標檢測算法與語義分割算法。商湯新加坡研究團隊打破慣例,探索了這兩項任務的互補性,提出了一種簡單高效的聯合訓練模型Panoptic-HTC。該模型分別借助Panoptic-FPN共享權重的特點與Hybrid Task Cascade聯合訓練的優勢,在特徵層面完成了兩項視覺任務的統一,從而同時在兩項任務上獲得顯著提升。

在Facebook AI Research主辦的第一屆LVIS Challenge 2019大規模實例分割比賽中,來自商湯科技研究院通用模型與工具鏈團隊獲得了冠軍,同時獲得該項目最佳論文獎。相比於以往的實例分割數據集,LVIS最大的特點在於超過1000多類的類別和更加接近于自然存在的數據長尾分佈。這些特點對現有的實例分割算法提出了非常大的挑戰。商湯研究團隊從原有模型訓練的監督方式進行分析,針對長尾問題提出了一種新的損失函數,能夠有效的緩解頻率高的類別對小樣本類別的影響,從而大大提升了處於長尾分佈中小樣本的性能。另外還通過對額外的檢測數據進行有效的利用,減少了因為LVIS數據集構建方式中帶來的標注不完全問題,從而進一步提升了性能。

此外,在Facebook AI Research主辦的ICCV 2019 自監督學習比賽中,來自香港中文大學-商湯科技聯合實驗室和南洋理工大學S-Lab團隊一舉獲得了全部四個賽道冠軍;在MIT主辦的ICCV 2019 Multi-Moments In Time Challenge比賽中,來自香港中文大學和商湯研究院的聯合團隊奪得了多標簽視頻分類賽道的冠軍;在Insight Face主辦的ICCV 2019 Lightweight Face Recognition Challenge比賽中,來自香港中文大學和商湯研究院的聯合團隊奪得了大模型-視頻人臉識別的冠軍;在ETH舉辦的ICCV AIM 2019 Video Temporal Super-Resolution Challenge比賽中,商湯科技AI畫質團隊獲得了冠軍;在視覺目標跟蹤領域國際權威比賽VOT2019 Challenge比賽中,來自商湯科技3D AR團隊獲得VOT-RT 2019實時目標跟蹤挑戰賽冠軍。

OpenMMLab成果豐碩,商湯以原創之心會四方學者

為了提高學術界算法的可複現能力以及推動行業學術交流,從2018年年中開始,香港中文大學-商湯科技聯合實驗室啟動OpenMMLab計劃,並首先開源了重磅物體檢測代碼庫MMDetection。相比於其它開源檢測庫,MMDetection有多項重要優點,包括高度模塊化設計、多種算法框架支持、顯著提高訓練效率和密切同步最新算法支持等。

MMDetection和MMAction作為視覺領域的重要任務,在商湯及聯合實驗室的研究人員共同努力下取得了豐碩成果。今年六月,OpenMMLab第二期發佈,多個重要更新吸引了業界目光:MMDetection(目標檢測庫)升級到1.0,提供了一大批新的算法實現,同時MMAction(動作識別和檢測庫),MMSkeleton(基於骨骼關鍵點的動作識別庫),MMSR(超分辨率算法庫)全新發佈。

今年ICCV 大會期間,MMDetection被業界廣泛應用,目前在GitHub上已收穫近7000 Stars,有效促進目標檢測領域的應用和新方法研究發展。

「科學不是一個人的事業 」,近代實驗科學奠基人伽利略在十六世紀就強調科學研究的交流合作的重要性。海納百川,取則行遠,為推動人工智能行業學術交流和發展,商湯科技在ICCV 2019期間還組織或參與主辦了多個Challenge及Workshop。

香港中文大學-商湯聯合實驗室的周博磊教授參與組織了上千人的Tutorial,該Tutorial主要探討可解釋機器學習的原因、典型方法、未來趨勢以及由此產生的可解釋機器學習的潛在工業應用。

由商湯科技參與舉辦的第一屆深度統計學習研討會(The First Workshop on Statistical Deep Learning in Computer Vision)和第二屆計算機視覺中的服裝藝術與設計研討會(Second Workshop on Computer Vision for Fashion, Art and Design),都邀請了來自MIT,Berkeley,UCLA,Stony Brook,Johns Hopkins University等多位知名教授在會上做主題報告和分享。

在ICCV展示區(Booth:A-1),商湯科技諸多創新AI產品也亮相世界舞臺,包括自動駕駛、SenseAR特效引擎Avatar 、SenseMatrix 物體3D重建 、SenseMatrix 人臉3D重建等11個產品為大會帶來豐富的體驗和創新靈感。

同時,在10月31日晚,商湯科技還將舉辦SenseTime PartyTime活動,邀請了來自CV界頂尖學者和科學家,與參會同學代表面對面交流、共話AI學術新動向,培養AI發展的未來生力軍。商湯願以原創之心,會四方學者。

商湯及聯合實驗室ICCV 2019論文精選

下面,列舉幾篇商湯及商湯聯合實驗室入選ICCV 2019的代表性論文,從四大方向闡釋計算機視覺和深度學習技術最新突破。

面向目標檢測的深度網絡基礎算子

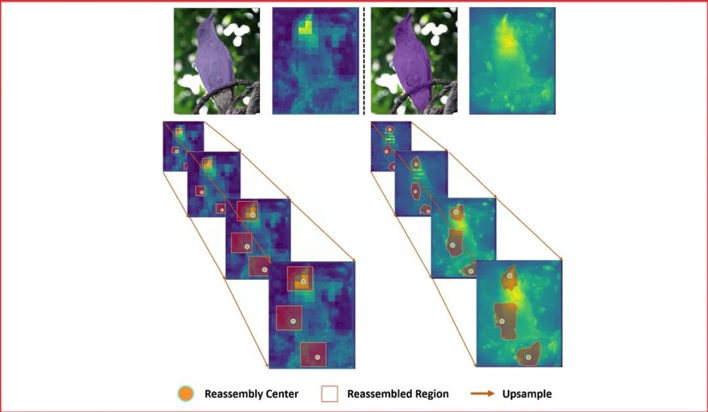

代表性論文:《CARAFE: 基於內容感知的特徵重組》

特徵上採樣是深度神經網絡結構中的一種基本的操作,例如:特徵金字塔。它的設計對於需要進行密集預測的任務,例如物體檢測、語義分割、實例分割,有著關鍵的影響。本工作中,我們提出了基於內容感知的特徵重組(CARAFE),它是一種通用的,輕量的,效果顯著的特徵上採樣操作。

CARAFE有這樣一些引人注目的特性:1.大視野。不同於之前的上採樣方法(如:雙線性插值),僅使用亞像素的臨近位置。CARAFE可以聚合來自大感受野的環境特徵信息。2.基於特徵感知的處理。不同於之前方法對於所有樣本使用固定的核(如:反卷積),CARAFE可以對不同的位置進行內容感知,用生成的動態的核進行處理。3.輕量和快速計算。CARAFE僅帶來很小的額外開銷,可以容易地集成到現有網絡結構中。我們對CARAFE在目標檢測,實例分割,語義分割和圖像修復的主流方法上進行廣泛的測試,CARAFE在全部4種任務上都取得了一致的明顯提升。CARAFE具有成為未來深度學習研究中一個有效的基礎模塊的潛力。

面向三維視覺的點雲處理基礎網絡

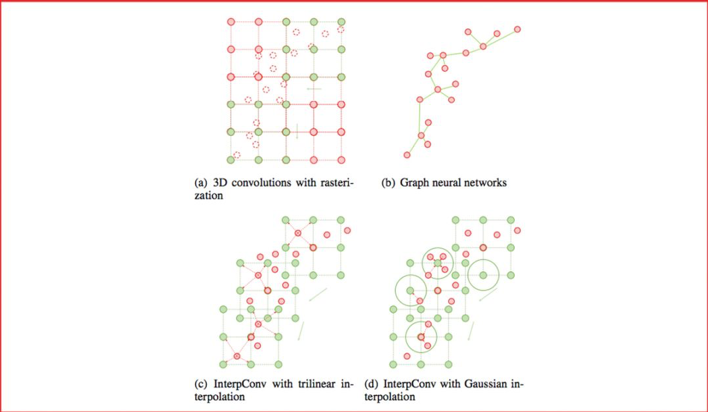

代表性論文:《基於插值卷積的點雲處理主幹網絡》

點雲是一種重要的三維數據類型,被廣泛地運用於自動駕駛等場景中。傳統方法依賴光柵化或者多視角投影,將點雲轉化成圖像、體素其他數據類型進行處理。近年來池化和圖神經元網絡在點雲處理中展現出良好的性能,但仍然受限於計算效率,並且算法易受物體尺度、點雲密度等因素影響。

本文提出了一種全新的卷積方式,即插值卷積,能夠從點雲中高效地學習特徵。插值卷積從標準圖像卷積和圖像插值中獲取靈感,卷積核被劃分成一組空間中離散的向量,每個向量擁有各自的三維坐標,當點雲中的某點落在卷積向量的鄰域時,參考圖像插值的過程,我們將該點對應的特徵向量插值到卷積向量對應的位置上,然後進行標準的卷積運算,最後通過正則化消除點雲局部分佈不均的影響。

面向不同的任務,我們提出了基於插值卷積的點雲分類和分割網絡。分類網絡採用多路徑設計,每一條路徑的插值卷積核具有不同的大小,從而網絡能夠同時捕獲全域和細節特徵。分割網絡參考圖像語義分割的網絡設計,利用插值卷積做降採樣。在三維物體識別,分割以及室內場景分割的數據集上,我們均取得了領先於其他方法的性能。

面向AR/VR場景的人體感知與生成

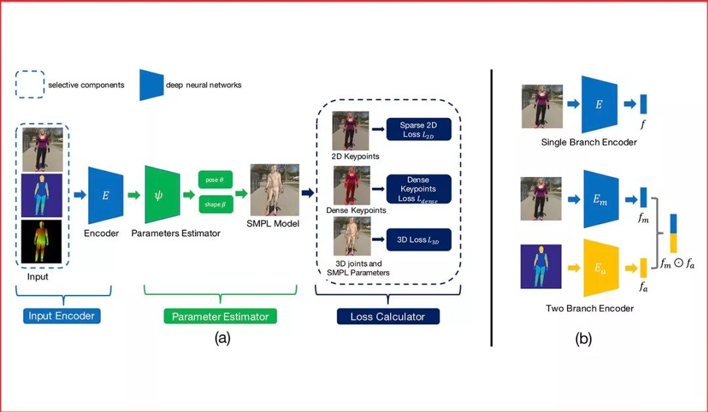

代表性論文:《深入研究用於無限制圖片3D人體重建中的混合標注》

雖然計算機視覺研究者在單目3D人體重建方面已經取得長足進步,但對無限制圖片進行3D人體重建依然是一個挑戰。主要原因是在無限制圖片上很難取得高質量的3D標注。為解決這個問題,之前的方法往往採用一種混合訓練的策略來利用多種不同的標注,其中既包括3D標注,也包括2D標注。雖然這些方法取得了不錯的效果,但是他們並沒有研究不同標注對於這個任務的有效程度。

本篇論文的目標就是詳細地研究不同種類標注的投入產出比。特別的,我們把目標定為重建給定無限制圖片的3D人體。通過大量的實驗,我們得到以下結論:1.3D標注非常有效,同時傳統的2D標注,包括人體關鍵點和人體分割並不是非常有效。2.密集響應是非常有效的。當沒有成對的3D標注時,利用了密集響應的模型可以達到使用3D標注訓練的模型92%的效果。

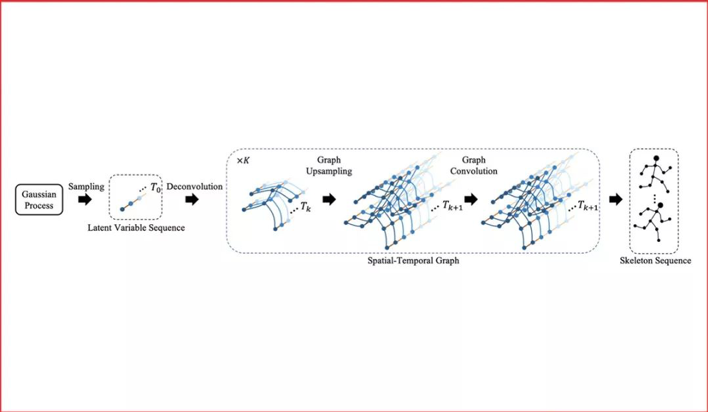

代表性論文:《基於卷積網絡的人體骨骼序列生成》

現有的計算機視覺技術以及圖形學技術已經可以生成或者渲染出栩栩如生的影像片段。在這些方法中,人體骨骼序列的驅動是不可缺少的。高質量的骨骼序列要麼使用動作捕捉設備從人身上獲取,要麼由動作設計師手工製作。而讓計算機代為完成這些動作,高效地生成豐富、生動、穩定、長時間的骨骼序列,就是這一工作的目標。

本文使用高斯過程產生隨機序列,使用對抗網絡和時空圖卷積網絡來學習隨機序列和動作序列之間的映射關係。該方法既可以產生動作序列,也可將動作序列映射到隨機序列所在的空間,並利用高斯過程進行編輯、合成、補全。

本方法在由真人動作捕捉得到的NTU-RGB+D數據集上,以及我們收集的虛擬歌手「初音未來」的大量舞蹈設計動作上,完成了詳細的對比實驗。實驗表明,相對于傳統的自回歸模型(Autoregressive Model),本文使用的圖卷積網絡可以大大提高生成的質量和多樣性。

面向全場景理解的多模態分析

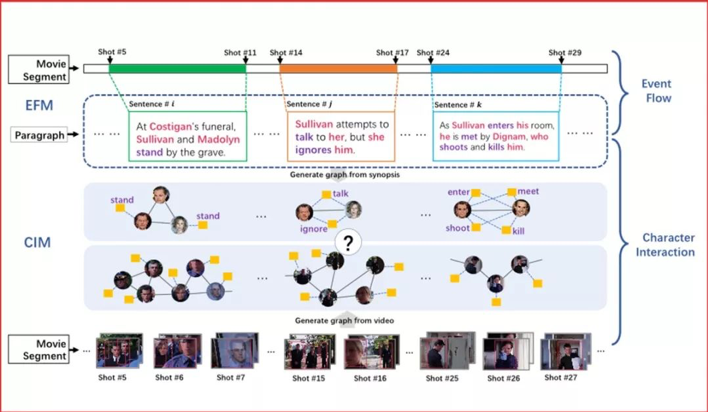

代表性論文:《基於圖匹配的電影視頻跨模態檢索框架》

電影視頻檢索在日常生活中擁有極大需求。例如,人們在瀏覽某部電影的文字簡介時,時常會被其中的精彩部分吸引而想要看相應的片段。但是,通過文字描述檢索電影片段目前還存在許多挑戰。相比於日常生活中普通人拍攝的短視頻,電影有著極大的不同:1.電影是以小時為單位的長視頻,時序結構很複雜。2.電影中角色的互動是構成故事情節的關鍵元素。因此,我們利用了電影的這兩種內在結構設計了新的算法來匹配文本段落與電影片段,進而達到根據文本檢索電影片段的目標。

首先,我們提出事件流模塊以建模電影的時序特性。該模塊基於二分圖匹配,將文本中的每一句話按照事件與電影片段的對應子片段匹配。其次,我們提出人物互動模塊,該模塊通過圖匹配算法計算文本中解析得到的人物互動圖和視頻中提取的人物互動圖的相似度。綜合兩個模塊的結果,我們能得到與傳統方法相比更精准的匹配結果,從而提高檢索的正確率。

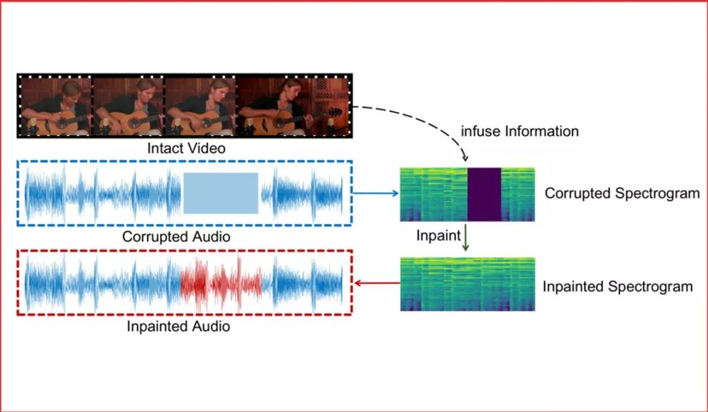

代表性論文:《融合視覺信息的音頻修復》

多模態融合是交互智能發展的重要途徑。在多媒體信息中,一段音頻信號可能被噪聲污染或在通信中丟失,從而需要進行修復。本文我們提出依據視頻信息對缺失音頻信息進行修復的一種融合視覺信息的音頻修復方案。

此方案核心思想在於:1.將音頻信號在頻譜上進行操作,並將頻譜作為二維圖像信號進行處理,可以極大地利用計算機視覺領域的優勢,超越傳統的音頻解決方案。2.為了融合視覺信息,基於音視頻同步學習得到的聯合子空間會發揮巨大的優勢。

針對此問題的研究,我們將已有的多模態樂器演奏數據集MUSIC擴大成為一個新的更全面的數據集,MUSICES。實驗證明我們提出的視覺融合的音頻修復系統可以在沒有視頻信息注入的情況下取得可觀的效果,並在加入視頻信息後,生成與視頻和諧的音頻片段。

返回

返回