- 新闻中心

商汤科技50篇论文入选CVPR 2024,“数字生命计划”加速创新应用

当地时间6月17-21日,全球人工智能计算机视觉领域顶级国际会议CVPR 2024(Computer Vision and Pattern Recognition,即国际计算机视觉与模式识别)在美国西雅图举行,共有来自全球的2719篇论文被接收,录用率为23.6%,相较去年下降2.2%,难度提升。

商汤科技及联合实验室的50篇论文成功入选,其中9篇被录用为Oral、Highlight,再创佳绩。伴随大语言模型(LLM)技术的爆发,商汤在本届CVPR的研究成果重点聚焦于推动视觉语言基础模型的提升及多模态技术的应用创新,其中有多篇涉及自动驾驶、机器人等前沿方向。

夯实基础模型能力,释放无限应用潜能

近年来,大语言模型的创新呈指数级增长,同时也为多模态系统开辟了诸多可能。大语言模型结合多模态技术能够更准确地模拟并理解人类的复杂行为和思维方式,这将进一步推动AI在自动驾驶、智能助手、医疗诊断等各行各业的创新和应用。

然而,目前视觉语言基础模型尚未跟上大语言模型的发展步伐,许多需要综合处理视觉和语言信息的场景无法充分发挥潜力。视觉语言模型的发展滞后会对创新研究和应用产生抑制作用,并导致资源浪费。

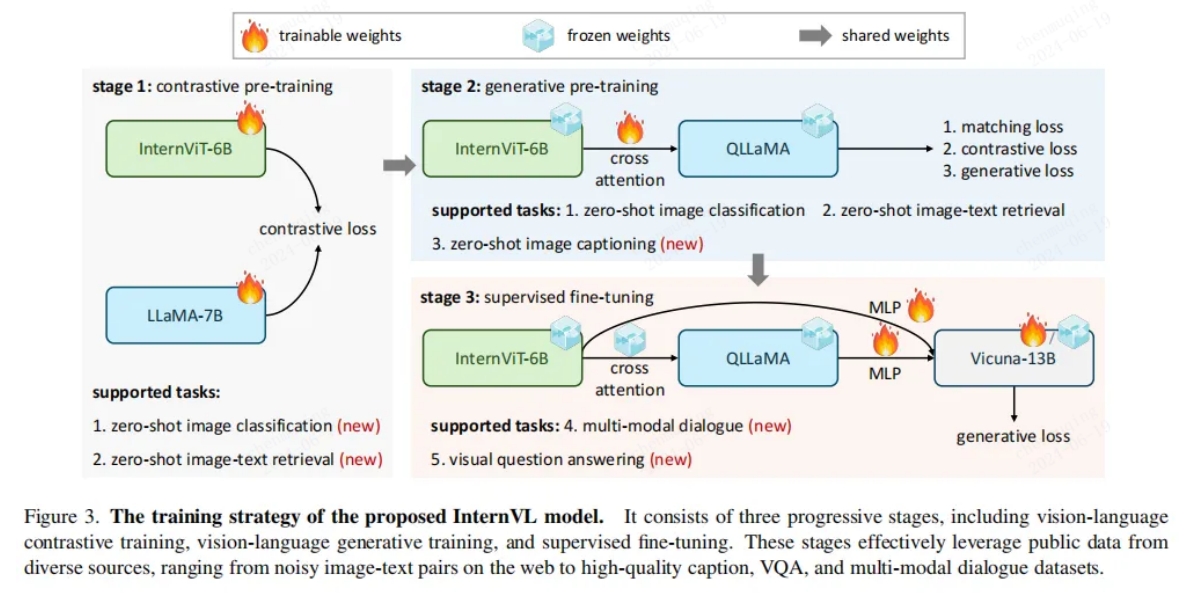

为此,商汤科技、上海AI实验室等联合设计了一个大规模的视觉语言基础模型——InternVL1,首次将大规模视觉编码器扩展到60亿个参数,与LLM进行对齐,在准确性、速度和稳定性之间取得了良好平衡。

(InternVL模型的训练策略)

为了有效训练大规模视觉语言基础模型,InternVL还引入了一种渐进式图像-文本对齐策略。该策略最大限度地利用网络规模的噪声图像-文本数据进行对比学习,并将细粒度、高质量的数据用于生成学习。通过验证,相较于当前最先进的视觉基础模型和多模态大语言模型,InternVL在广泛的通用视觉语言任务上能够取得更领先的结果。

另外,InternVL工作的最新版本InternVL 1.5 2具备强大的视觉编码器和更深层次的场景理解能力;支持动态高分辨率,能够准确识别和理解图像中的各种细节以及文字信息。第三方评测结果显示,InternVL 1.5在多模态感知、通用问答、文档理解、信息图表理解以及数理理解等方面综合能力领先开源模型,比肩GPT-4V、Gemini Pro等闭源模型。

不仅如此,为了补充多模态系统在高质量图像生成中的优质表现,对传统模型进行优化,商汤还提出了一个“基于时间信息块的时间特征维护量化(TFMQ)”扩散模型框架3。该框架时间信息块仅与时间步骤相关,与采样数据无关,创新地设计并引入了时间信息感知重建(TIAR)和有限集校准(FSC)方法,从而可以在有限的时间内对齐全精度时间特征,最小化精度损失的同时提高图像生成效率。

配备此框架,可以保持最多的时间信息并确保端到端的图像生成质量。在各种数据集和扩散模型上的广泛实验证明了该技术已经达到SOTA水平。

3D感知、数字生命,机器人应用越来越近

随着多模态能力的不断提升,大模型在AI智能体、机器人,乃至具身智能领域有着非常重要的应用前景。它可显著提升对复杂环境的感知、决策和执行能力,使其不仅能理解和响应自然语言指令,还能通过视觉识别分析环境。

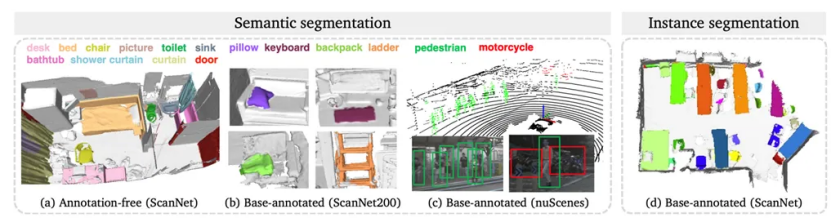

场景级别的3D开放世界感知更是机器人领域非常重要的能力之一,它能够使机器人在复杂、多变的环境中自主导航、理解和交互,从而提升执行复杂任务的效率、准确性和安全性。

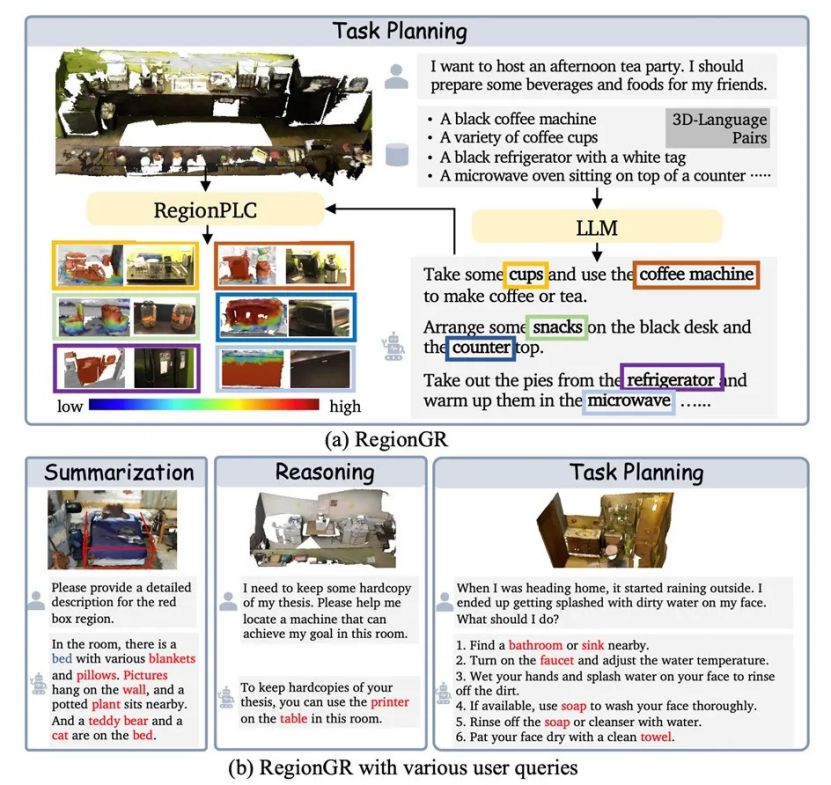

商汤科技和联合实验室的研究团队提出了一种直接结合点云和自然语言的新开放世界理解算法——RegionPLC4,无需额外训练就可以和大语言模型结合进行一些场景级别的开放问答。该算法扩展到了更细粒度的区域级别点云和语言的结合,能够生成更密集和细粒度的描述。

在该研究中,研究人员设计了一种基于互补的数据混合策略SFusion,只会混合在3D空间中互补的 3D-text pairs,减少在优化时产生冲突的概率。这样的设计使得 RegionPLC 可以结合不同 2D 大模型的优势,达到更好性能。

通过大量实验证明,RegionPLC 在室内和室外场景中明显优于先前的开放世界方法,并在具有挑战性的长尾或无注释场景中表现非常出色。

除了对场景的识别和理解,智能体的社会化交互能力也是人工智能迈向更高阶的关键所在。通过增强社会化交互能力,它们可以更有效地与人类和其他智能体进行沟通、交互和合作,创造更多新的价值和可能性。

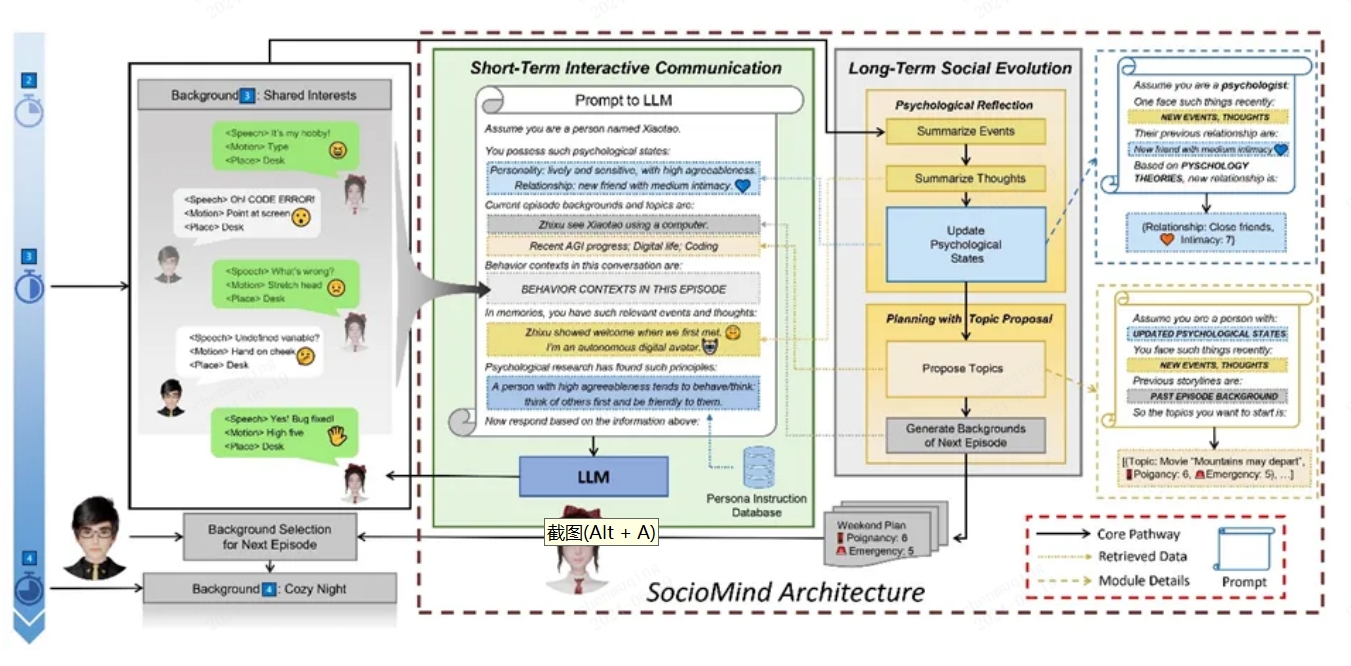

为此,商汤及联合实验室提出了“数字生命计划(Digital Life Project)5”,即通过AI技术和动作合成技术创造出能够在数字环境中模拟交互的自主3D虚拟角色。这些角色不仅可以进行对话,还将拥有自己的人格,并感知所处的不同社交环境,做出相对应的身体动作来表达情感和反应。

数字生命计划的包括“SocioMind”和“MoMat-MoGen”两个核心部分。其中,SocioMind是一个模拟人类思想和判断的数字大脑。它能够利用近期发展非常迅猛的大语言模型,结合基于心理学原理的反思过程,并通过发起对话主题来模拟具有自主性的角色。SocioMind能够使角色自主地发起和参与对话,规划接下来的故事发展。

(SocioMind数字大脑的架构总览)

而MoMat-MoGen是一套用于控制角色身体动作的3D系统。它结合了动作匹配(Motion Matching)和动作生成(Motion Generation)技术,在数字大脑的驱动下,匹配并生成高精度且丰富的动作,让角色能根据场景做出合理的反应。

(MoMat-MoGen数字身体的架构总览)

这两个系统的结合能够创造出能够进行复杂社交互动的3D虚拟角色,在新媒体内容创作、3D虚拟陪伴、大规模虚拟社区等领域有着非常广泛的应用潜力。数字生命计划探索了数字大脑的可能,使得智能体变得具有灵性,结合对于3D场景的理解和交互,使得机器人和具身智能的应用离人类越来越近。

商汤科技在学术研究及技术创新方面取得的突出成绩,离不开领先的软硬件基础设施整合的强大算力基础和领先的算法能力,以及商汤在学术生态和开源生态建设方面的长期积累。

基于眼光更长远的“大模型+大装置”战略布局,商汤科技联合各大实验室,不断完善AI学术生态,通过大量学术创新成果,并结合自身在AI技术落地的多年实践经验,为生成式AI和大模型的产业应用开拓了新的方向。

参考文献:

1. InternVL: Scaling up Vision Foundation Models and Aligning for Generic Visual-Linguistic Tasks

2. https://arxiv.org/pdf/2404.16821

3. TFMQ-DM: Temporal Feature Maintenance Quantization for Diffusion Models

4. RegionPLC: Regional Point-Language Contrastive Learning for Open-World 3D Scene Understanding

5. Digital Life Project: Autonomous 3D Characters with Social Intelligence

返回

返回