- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

商研丨三次成功挑战目标跟踪算法极限,入选ECCV、CVPR Oral的SiamRPN系列已开源

人工智能应用在自动驾驶、智慧交通、智慧零售等场景的时候,往往需要识别和跟踪动态的人或物体。由于存在遮挡、光照变化、尺度变化等一系列问题,目标跟踪(Object Tracking)一直都存在较大挑战。

近日,商汤目标跟踪SiamRPN系列算法的SiamRPN++又获得新突破,入选了CVPR 2019 (Oral),在多个数据集上都完成了10%以上的超越,并且是SOTA(效果最好的)算法。

以上动图中,红色框是SiamRPN++的跟踪效果,蓝色框是ECCV 2018上的UPDT的结果,可以看出SiamRPN++的效果更佳,跟踪效果更稳定,框也更准。从这个图也可以看出跟踪的一些挑战:光照急剧变化,形状、大小变化等。

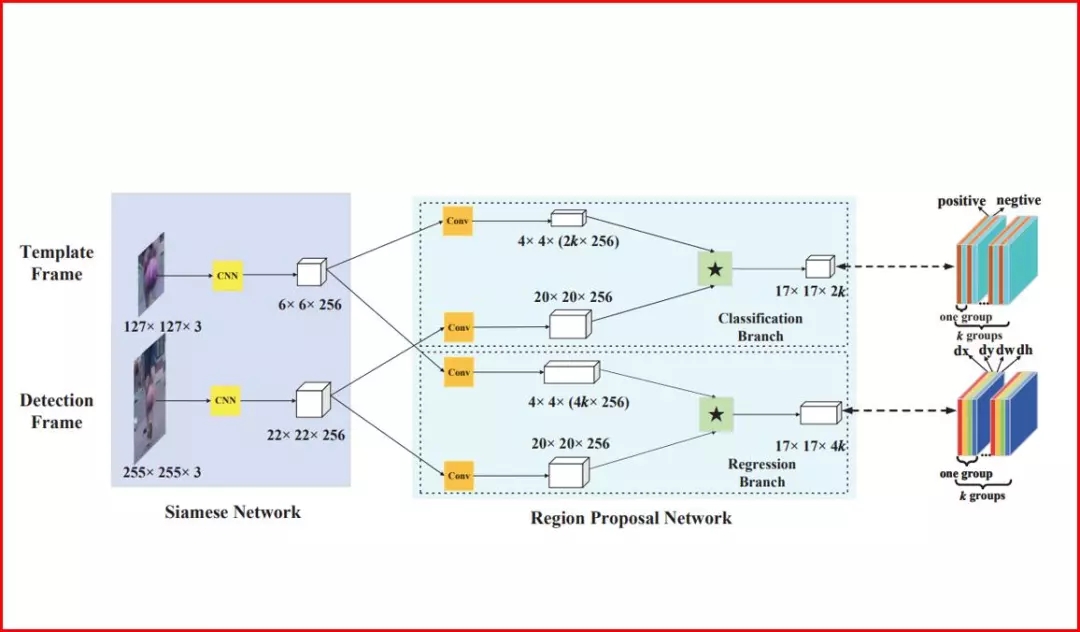

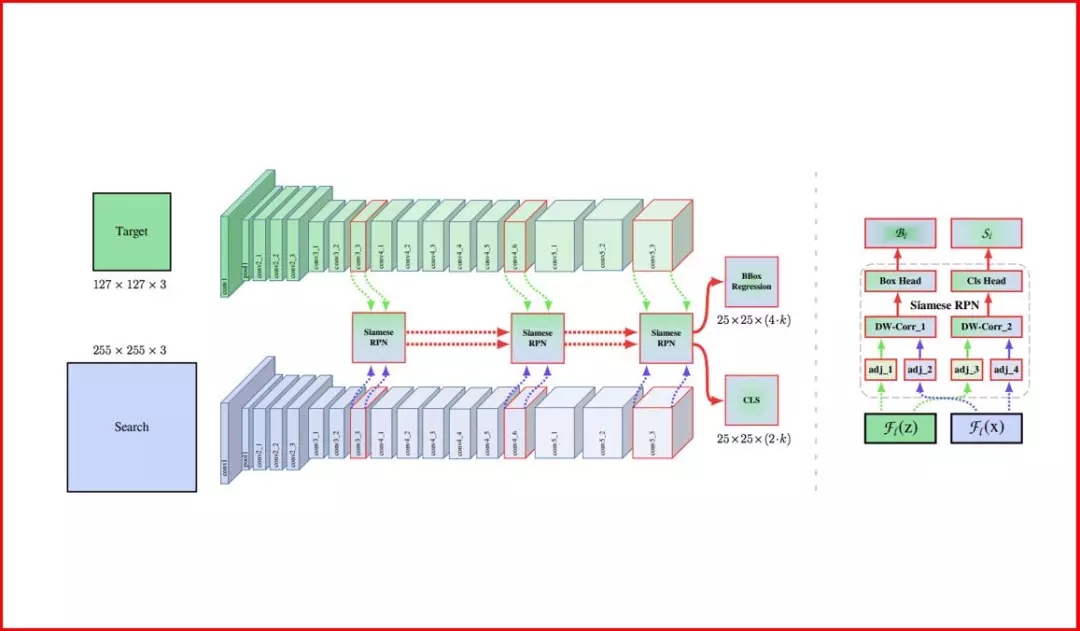

目标跟踪有一个“特殊大脑”——孪生网络(Siamese Network),简单来说,就是左右两个神经网络的权重一样,提取的特征相似。如下图所示:

历经数年,商汤智能视频团队围绕着孪生网络的目标跟踪算法技术潜心研究,并将研究成果总结发表了三篇系列论文,均被国际知名计算机视觉会议录用。这三篇论文分别为入选CVPR 2018的SiamRPN,获得ECCV2018的VOT Workshop冠军的DaSiamRPN,以及刚刚又入选CVPR 2019 (Oral)的SiamRPN++。

想了解目标跟踪SOTA算法是如何炼成的吗?商汤君呈上三篇系列论文解读,由浅入深为您一一道来。

第一篇论文SiamRPN:将检测算法引入到跟踪

目标跟踪是指在视频中框定第一帧中目标的位置并在后续帧中进行跟踪。虽然孪生网络能对目标快速定位,但不能对目标框作出调整,无法对跟踪目标的形状进行调节。跟踪不只是定位和比对,它对目标框(可理解为目标范围)的回归预测一样重要。

SiamRPN将检测中的区域推荐网络引入到跟踪中的孪生网络:孪生网络可以利用被跟踪目标的信息;区域推荐网络可以对目标位置进行更精准的预测。通过两者的结合,SiamRPN可以进行端到端的训练,让跟踪的框变的更加精准。

除了算法上的创新,SiamRPN还在数据上发力,采用了更大规模的数据训练集Youtube-BB(大约是VID的50倍),进一步提升了跟踪的性能。

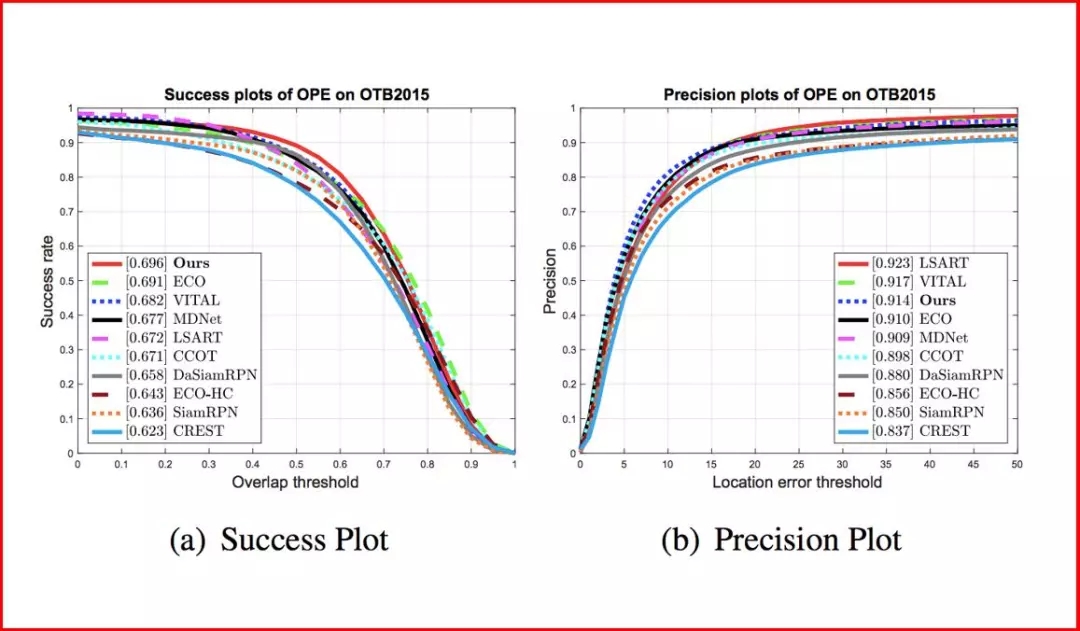

结合以上两点创新,在基线算法SiamFC(卷积孪生网络)的基础上,SiamRPN实现了五个点以上的提升(OTB100,VOT15/16/17数据集),同时还达到了更快的速度(160fps),更好地实现了精度与速度的平衡。SiamRPN论文被CVPR 2018(Spotlight)录用。

第二篇论文DaSiamRPN:改进训练数据集,增强判别能力

SiamRPN虽然取得了非常好的性能,但它的训练集主要来自VID和YoutbeBB,物体类别非常少,仅二三十类,难以满足目标跟踪的通用类别的需求,只“认识”几十种类别的图像可不行。

那么如何解决数据类别不足的问题呢?

我们知道,COCO和ImageNet Det的检测数据集分别有八十类和两百类,所以商汤智能视频团队尝试将这两个检测数据集引入进来。孪生网络的训练只需要图像对,而并非完整的视频,所以检测图片也可以被扩展为跟踪训练数据。

但将检测数据集引入跟踪之后,又发现一个新的问题:这个网络会对所有有语义的样本进行响应,而不是仅仅对目标物体进行响应。比如让它跟踪一个人,但它遇到一个椅子也会有很高响应。因为在之前的训练方式中,负样本(和目标无关的样本)只有背景信息,这一定程度上限制了网络的判别能力。

研究就是不断遇到问题解决问题的过程,研究人员在DaSiamRPN中又改进了方法——增加了一些有语意的负样本对来增强跟踪器的判别能力,即训练过程中不再让模板和搜索区域是相同目标;而是让网络学习判别能力,去寻找搜索区域中和模版更相似的物体,而并非一个简单的有语义的物体。

经过上述的改进,网络的判别能力变得更强,检测分数也变得更有辨别力,这样就可以根据检测分数判断目标是否消失。基于此,DaSiamRPN可以将短时跟踪拓展到长时跟踪,并且在UAV20L数据集上比之前最好的方法提高了6个点。

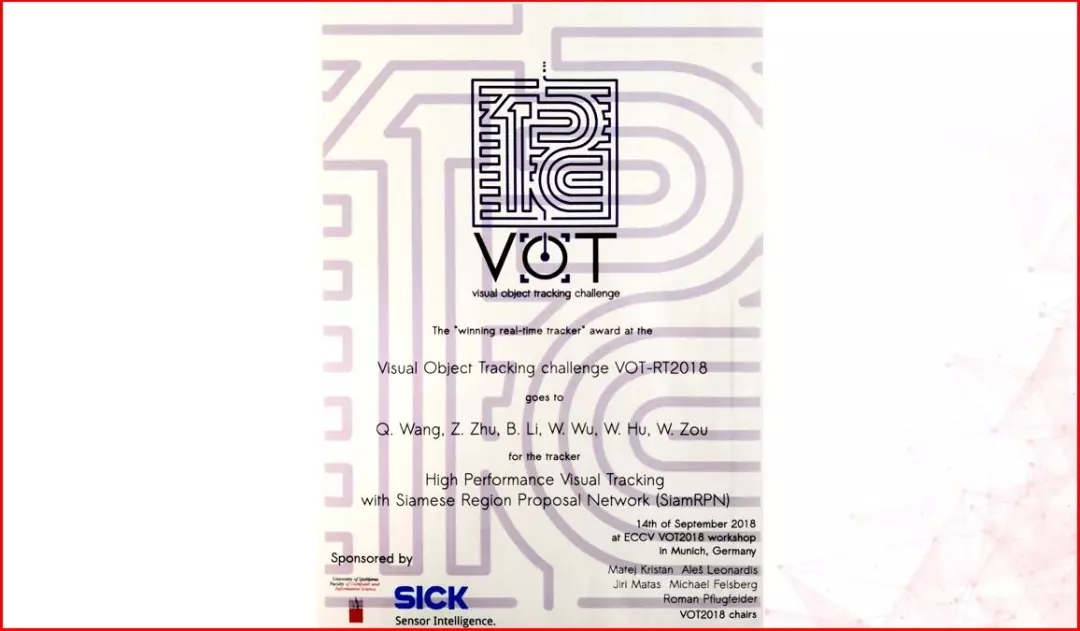

DaSiamRPN也被 ECCV 2018 收录,而且在ECCV 2018的VOT workshop上面,DaSiamRPN取得了实时比赛的冠军,相比去年的冠军有了80%的提升。

第三篇论文SiamRPN++:对孪生网络本身“下刀子”,利用深网络

以上孪生网络在算法和训练数据集上都做了改进,应该没有什么可以再改进的地方了吧?

NO!还有!商汤智能视频团队的研究人员还对孪生网络本身“下刀子”。之前的孪生网络都是基于比较浅的卷积网络(如AlexNet),无法利用深网络为跟踪算法提升精度。

但深网络不能直接引入,否则会有反作用——性能大幅衰减。

引入深网络之前需要先缓解位置偏见问题,研究人员通过提出在训练过程中加入“位置均衡的采样策略”来缓解这一问题,让深网络能够发挥出应有的效果。

在缓解了这一问题后,深网络能够用在孪生网络中,不但可以跟踪更多细节信息(浅层网络特征),而且能跟踪更多语义信息(深层网络特征),利用多层融合信息进一步提升性能。

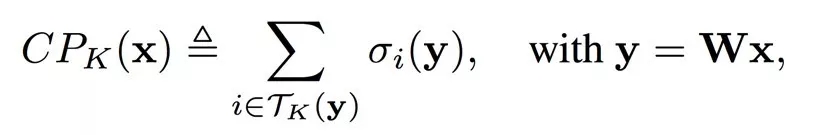

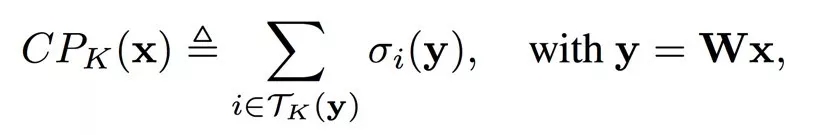

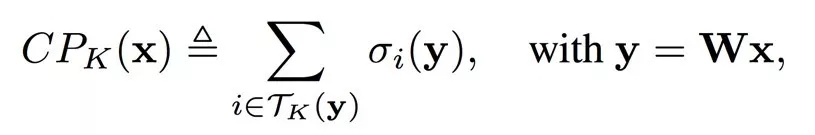

同时,论文还提出了新的连接部件,深度可分离相关层(Depthwise Correlation,后续简写为DW)。相比于之前的升维相关层(UpChannel correlation,后续简写为UP),DW可以极大地简化参数量,平衡两支的参数量,同时让训练更加稳定,也能更好的收敛。

为了验证以上提出的内容,研究人员做了详细的对比实验。在比较常用的VOT和OTB数据集上,SiamRPN++取得了SOTA的结果。

在VOT18的长时跟踪,以及最近新出的一些大规模数据集上,如LaSOT,TrackingNet,SiamRPN++也都取得了SOTA的结果。

SiamRPN++论文也已经被CVPR 2019 Oral录用,详情可查看论文《SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks》。

https://arxiv.org/abs/1812.11703

另外,商汤科技智能视频团队也首次开源了目标跟踪研究平台PySOT,包含目标跟踪SOTA算法SiamRPN++和SiamMask等算法。开源地址可访问 https://github.com/STVIR/pysot,或点击左下角“阅读原文”。

参考文献:

1. Bo Li, Wei Wu, Qiang Wang, Fangyi Zhang, Junliang Xing, Junjie Yan, "SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks" (Oral) in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR) 2019.

2. Zheng Zhu, Qiang Wang, Bo Li, Wei Wu, Junjie Yan, "Distractor-aware Siamese Networks for Visual Object Tracking" European Conference on Computer Vision (ECCV) 2018.

3. Bo Li, Junjie Yan, Wei Wu, Zheng Zhu, Xiaolin Hu, "High Performance Visual Tracking with Siamese Region Proposal Network" (Spotlight) in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR) 2018.

4. Luca Bertinetto, Jack Valmadre, João F. Henriques, Andrea Vedaldi, Philip H. S. Torr

"Fully-Convolutional Siamese Networks for Object Tracking" in ECCV Workshop 2016.

5. Goutam Bhat, Joakim Johnander, Martin Danelljan, Fahad Shahbaz Khan, Michael Felsberg."Unveiling the Power of Deep Tracking" European Conference on Computer Vision (ECCV) 2018.

返回

返回