- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

CVPR 2018 | 商汤科技Spotlight论文详解:基于孪生区域推荐网络的高性能单目标跟踪

距离CVPR 2018大会越来越近,本文是商汤科技在目标检测与跟踪领域,发表的一篇CVPR 2018亮点报告论文:基于孪生区域推荐网络的高性能单目标跟踪。该论文由商汤科技见习研究员李搏在研究院副院长闫俊杰和研究员武伟共同指导下完成。

论文:基于孪生区域推荐网络的高性能单目标跟踪

作者:Bo Li, Junjie Yan, Wei Wu, Zheng Zhu, Xiaolin Hu

论文链接:http://openaccess.thecvf.com/content_cvpr_2018/CameraReady/2951.pdf

简介

本论文提出一种端对端的单目标跟踪算法,实现高性能的单目标视觉跟踪。现有的单目标跟踪算法通常很难兼顾跟踪性能和速度,只能在某一项指标占优。本文利用孪生(Siamese)网络和区域候选网络(Region Proposal Network),构建了一种高速且高精度的单目标跟踪算法。算法在整体框架上,可被分为孪生(Siamese)特征提取网络和区域推荐网络(Region ProposalNetwork)两个子网络,在一个统一的框架里实现端到端的训练和测试。

训练过程中,算法能够同时利用密集标注(VID)和稀疏标注(YoutubeBB)的数据集进行训练,相比于现有方法,稀疏标注的数据集大大增加了训练数据来源,从而可以对深度神经网络进行更充分的训练;区域推荐网络中的坐标回归则可以让跟踪框更为准确,节省了传统孪生跟踪网络中多尺度测试所需的额外计算。

实验方面,本文跟踪算法能在保持160fps的高帧率情况下,在VOT2015和VOT2016等数据集上取得匹敌目前先进水平的结果。

设计思想

单目标视觉跟踪领域的主流方法是以SiameseFC为代表的孪生网络结构,SiameseFC网络结构简单,通过同一网络提取一对图像的特征,通过相关(correlation)操作,可以实现目标模板与搜索图像区域中的17x17个小图像的快速比对,输出的17x17的响应图,描述每个图像搜索位置与目标模板的相似度。但SiameseFC有以下缺陷:

首先,网络无法预测目标尺度上的变化,因此只能通过多尺度测试来判断目标尺度的变化,降低跟踪速度。

其次,输出的模板响应图分辨率较低,为了得到更高精度的位置,SiameseFC需要采用插值的方法,将响应图分辨率放大16倍,达到与输入图像尺寸相近的大小。

本文提出SiameseRPN算法,通过引入物体检测领域中的区域推荐网络(RPN),回归目标框位置,避免SiameseFC中响应图插值和多尺度测试等操作,既提升了速度又得到更为精准的目标框。在训练过程中,算法能够使用大规模带稀疏标注的视频数据集Youtube-BB进行训练,相较于SiameseFC仅使用的VID数据集,Youtube-BB数据集能够提供50倍数量的视频,保证了深度神经网络能够被充分的训练。

训练框架

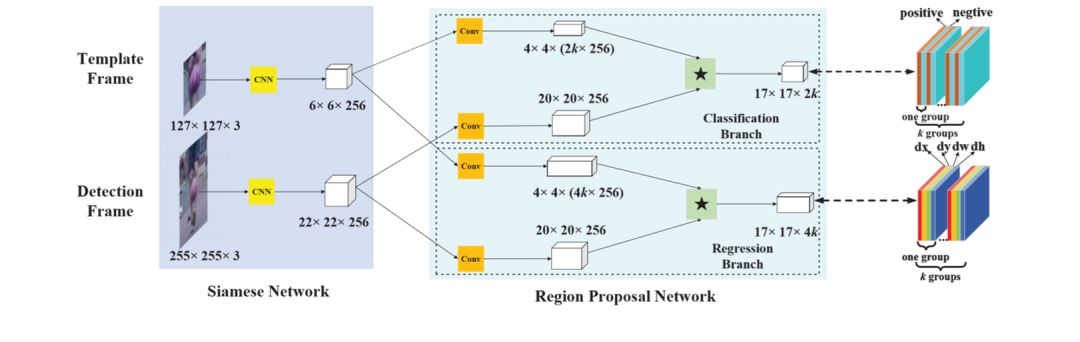

图1展示了SiameseRPN的整体网络框架:

左边是用于提取特征的孪生(Siamese)网络;中间是区域推荐网络,包含了分类分支和回归分支,通过输入成对图像并进行相关(correlation,图1中“*”)等操作得到最后的输出。

图1:算法整体网络结构

图1右边部分展示了各输出通道的细节:在分类分支,输出的前景置信图包含2k个通道,分别表示响应图每个位置k个锚点框的前景/背景的置信度;在回归分支,输出图包含4k个通道,分别表示每个位置k个锚点框的坐标偏移量。

孪生网络

孪生网络用于提取输入图像的特征,分为模板分支和检测分支,均采用全卷积网络结构生成输入图像的视觉特征图。模板分支的输入为模板帧的目标图像 (z),而检测分支的输入为当前帧的图像 (x),φ(z)和φ(x)则分别代表两支网络输出的目标特征图和当前帧特征图。两支网络只有输入不同,而权重参数完全相同,因而可以隐式的编码相同的图像视觉变化,适用于跟踪任务。

区域推荐网络

区域推荐网络负责基于目标特征图φ(z)和当前帧特征图φ(x),及相关操作的结果(即1*17*17的响应图),预测目标的精准位置。若每个输出位置有k个锚点框(anchor box),那么网络需要为分类分支输出通道数为2k的置信图,为回归分支输出通道数为4k的偏移图。

因此在进行相关操作之前,网络使用卷积操作提升两个分支中特征图的通道数,将其分别提高为原来的2k倍和4k倍,图1中间部分的卷积用于提升特征图维度。提升维度后的特征图进行相关操作,得到分类和回归分支的输出。两支网络利用与目标检测中Faster R-CNN算法类似的损失函数,进行网络训练。

训练数据的构成

在训练阶段,Siamese网络所需要的训练样本对从VID和Youtube-BB数据集中以随机间隔筛选生成。目标模板和检测帧图像来自于同一个视频中同一个物体的不同两帧。两帧之间通常有一定间隔,但过远的间隔可能使得目标外观的变化过大,使得网络难以训练。因此,在实际训练过程中均采用小于100帧间隔的图像对作为训练样本对。

虽然在视频数量上Youtube-BB数据集远大于VID数据集,但VID数据集包含Youtube-BB数据集所不具备的高帧率标注。本文观察到,一个好的跟踪网络既需要能够捕捉目标细粒度的变换(由VID数据集得到),又需要从更大数量级的视频中学习更加通用的目标特征和变化(通过Youtube-BB数据集学习),因此两个数据集的合并使用十分重要,且需要调整好训练数据的比例。本文实验中,VID和Youtube-BB的数据占比设为1:5。

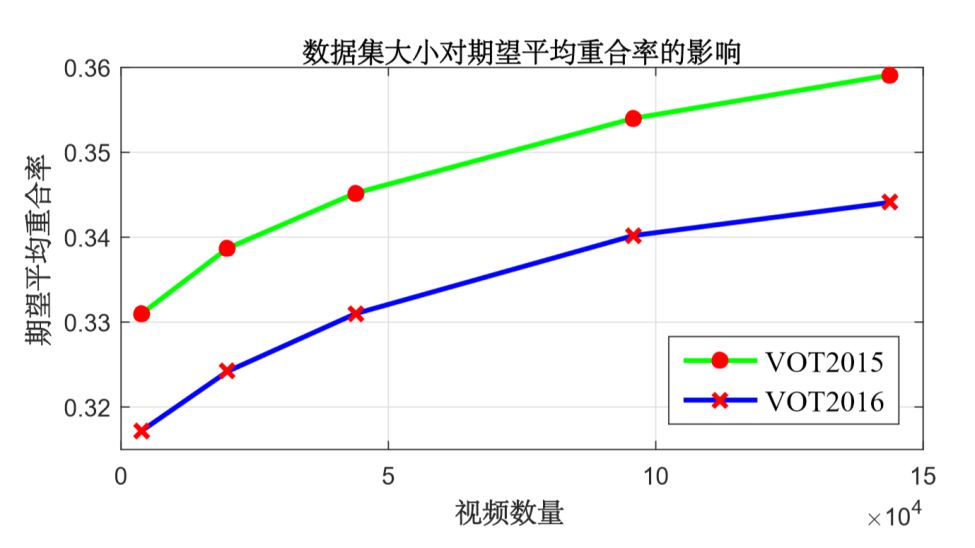

图2:不同量级训练数据对应的

最终模型跟踪性能

本文在不同数量视频的训练集下训练SiameseRPN。如图2所示,最左边的跟踪精度代表只用VID作为训练集的情况,可以看出,随着数据不断的增加,在VOT2015和VOT2016测试集上跟踪性能均不断提升,Youtube-BB数据集的引入让算法在VOT2016上的EAO从0.317提升至0.344,超过VOT2016的冠军方法CCOT,并且从曲线趋势上来看,跟踪性能还没有趋于饱和。这表明如果能够有更大量级的数据集,模型的跟踪精度能够进一步提升。这也就体现了数据驱动算法的优势。当目标跟踪与其它计算机视觉领域一样,出现了大量的跟踪数据集时,深度学习算法可以通过增加数据获得更好的性能,而传统的滤波方法不能采用离线训练,也无法有效的利用大数量级的跟踪数据。

算法测试流程

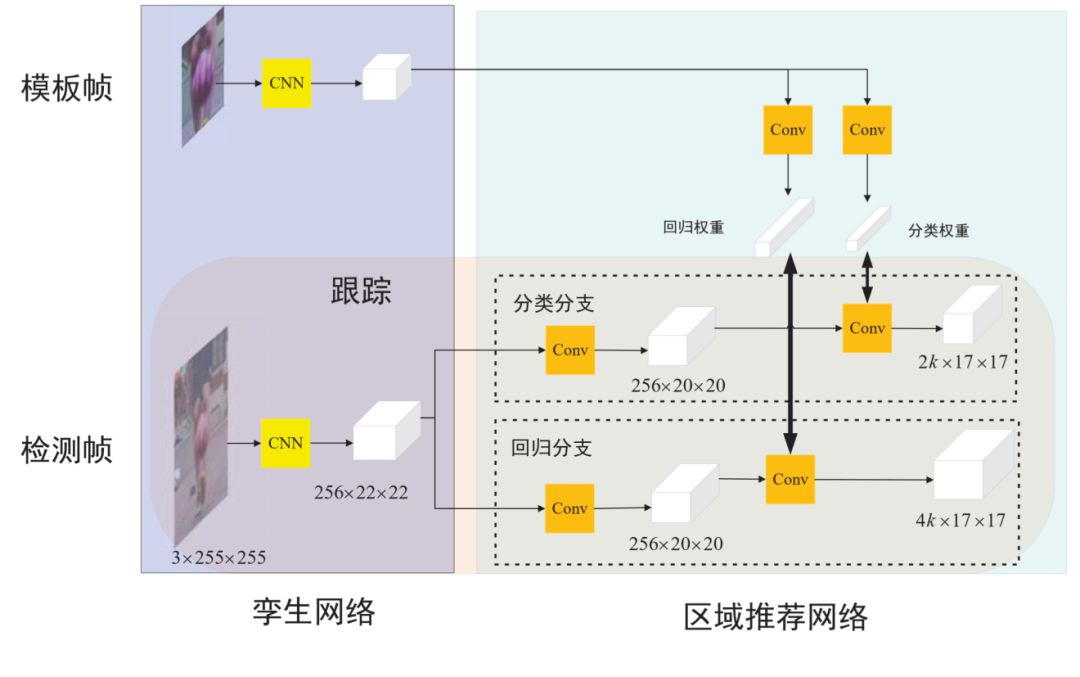

与训练过程不同,孪生网络的两支在测试过程中被分离开(如图3所示),模板支只在目标初始帧前向传播一次,将用于前景置信度和偏移预测的特征图计算好以后保留至内存。而检测分支则在视频每一帧进行前向传播,得到对应的用于前景置信度和偏移预测的特征图,将其与模板对应的特征图进行相关操作以后,得到最终的前景/背景分类结果和目标框偏移回归结果。根据这两个结果图,可以得到每个预测框的目标置信度,经过高斯窗口抑制和形状抑制,得到加权后的目标置信度。算法选出置信度最高的对应框,作为网络预测的最终目标位置。

图3:SiameseRPN算法测试流程

实验结果

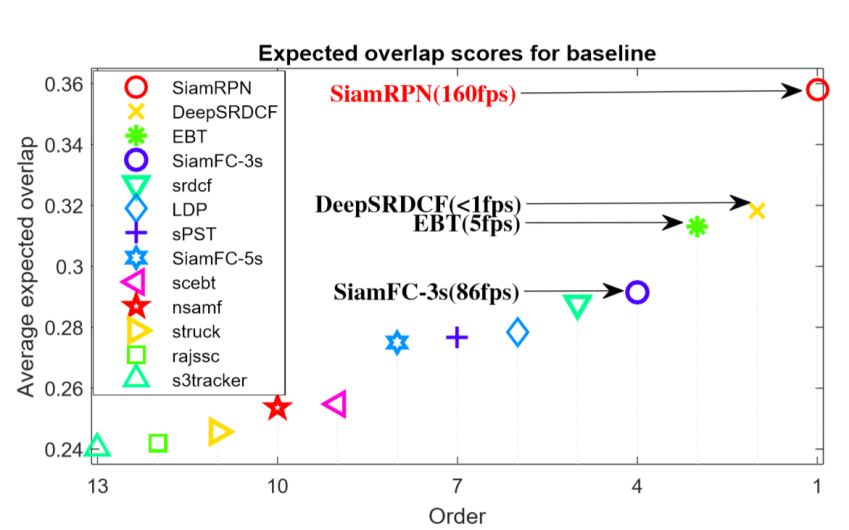

VOT2015结果

VOT2015数据集中包含60段视频。在测试过程中,当VOT工具包发现跟踪结果与实际目标位置重合度为0时会重启跟踪器,因此跟踪算法的性能由精度和鲁棒性两方面来评估。精度度量跟踪过程中平均的目标框重合度,而鲁棒性则衡量跟踪算法在测试视频上的丢失次数,VOT提出了EAO来综合这两项指标,作为排名依据。不同算法的跟踪精度如图4所示,本文提出的SiameseRPN算法可以在速度极高的情况下依然保证跟踪性能的领先,在速度和精度上均领先于第二名。

图4:不同跟踪算法

在VOT2015测试集的性能

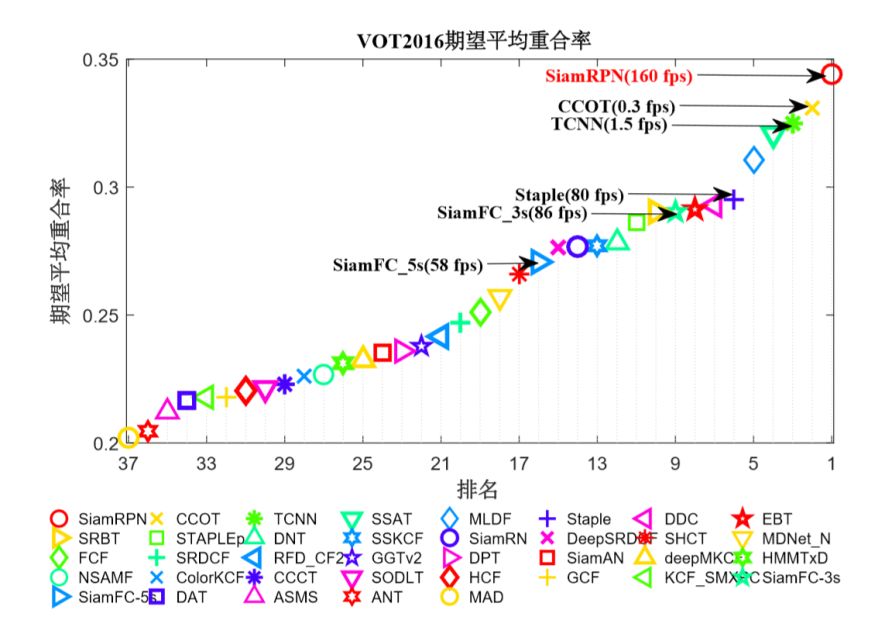

VOT2016 结果

VOT2016测试数据集与VOT2015数据集相同,但是使用了更为更紧致的目标框,因此跟踪算法更容易丢失目标,造成跟踪重启。不同算法在VOT2016数据集的性能如图5所示,本文提出的算法与榜单上的前25名的算法进行了对比,SiameseRPN算法仍然能够在该数据集夺得第一名,其速度(160fps)是VOT2016冠军算法的500倍。

图5:不同跟踪算法

在VOT2016测试集的性能

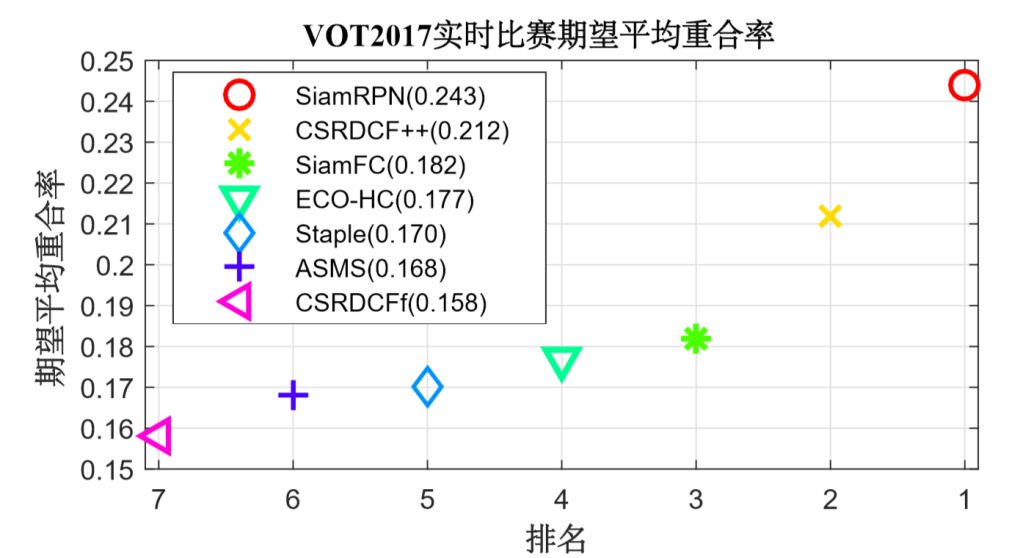

VOT2017 数据集实时跟踪结果

在VOT2017数据集中,VOT中10段最简单的视频被替换为了十段较难的视频。同时实验新增了实时比赛,要求跟踪算法必须能够在每秒处理20帧图像。若算法不能在50ms内完成处理当前帧,则使用上一帧结果代替。该规定导致速度较慢的跟踪算法会丢失多帧跟踪结果,无法有效跟踪目标。

图6:不同跟踪算法

在VOT2017测试集的实时跟踪性能

如图6所示,本文算法在实时跟踪榜单同样排名第一,0.24平均重合率的成绩较第二名CSRDCF++平均重合率提高3个点,同时相较于SiameseFC算法(实时榜单的冠军),平均重合率提高6个点。实验结果非常有力地证明了本文算法能够在高帧率的同时保证精准的跟踪精度。

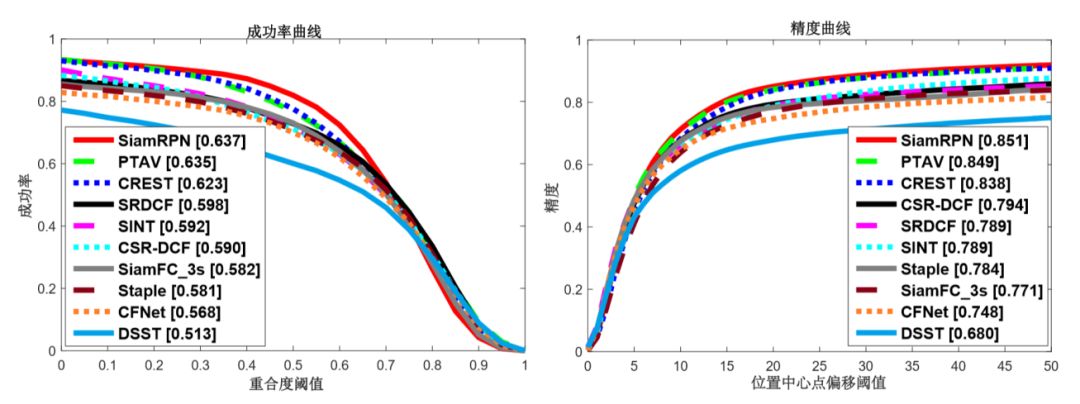

OTB2015数据集结果

OTB数据集由跟踪社区经常使用的视频中挑选出的100段视频组成,主要评测指标包含成功和精度的曲线。精度曲线度量预测框与标注中心点小于某像素的帧的占比;成功率曲线则度量预测框与标注框的重合度超过某一阈值的帧的占比。本文将孪生区域推荐网络和几个比较有代表性的算法进行了对比,包含PTAV、CREST、SINT、CSR-DCF、SiameseFC、Stape、CFNet、DSST。结果如图7所示,本文提出的算法可以在OTB2015的两个指标上均取得第一。由于引入了区域推荐网络,新算法可以比基础算法SiameseFC提高5个点。

图7:不同跟踪算法在OTB2015数据集上的

成功率曲线和精度曲线

结论

本文利用孪生网络和区域推荐网络,构建了一种高速且高性能的单目标跟踪算法。算法中设计的坐标回归可以让跟踪框更加准确,并且省去多尺度测试耗费的时间。在实验中,本文跟踪算法能在保持高速的情况下(160fps),在VOT2015和VOT2016数据集上均达到领先的单目标跟踪水平。

返回

返回