- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

ICCV 2021 _ 当图卷积遇上多视角3D人体姿态估计

Graph-Based 3D Multi-Person Pose Estimation Using Multi-View Images

Size Wu1,3 Sheng Jin2,3 Wentao Liu3 Lei Bai4 Chen Qian3 Dong Liu1 Wanli Ouyang4 1University of Science and Technology of China 2The University of Hong Kong 3SenseTime Research and Tetras.AI 4The University of Sydney

Wsz32741010@mail.ustc.edu.cn {jinsheng, liuwentao, qianchen}@sensetime.com baisanshi@gmail.com dongeliu@ustc.edu.cn wanly.ouyang@uni.sydney.edu.au

Part 1 动机和背景

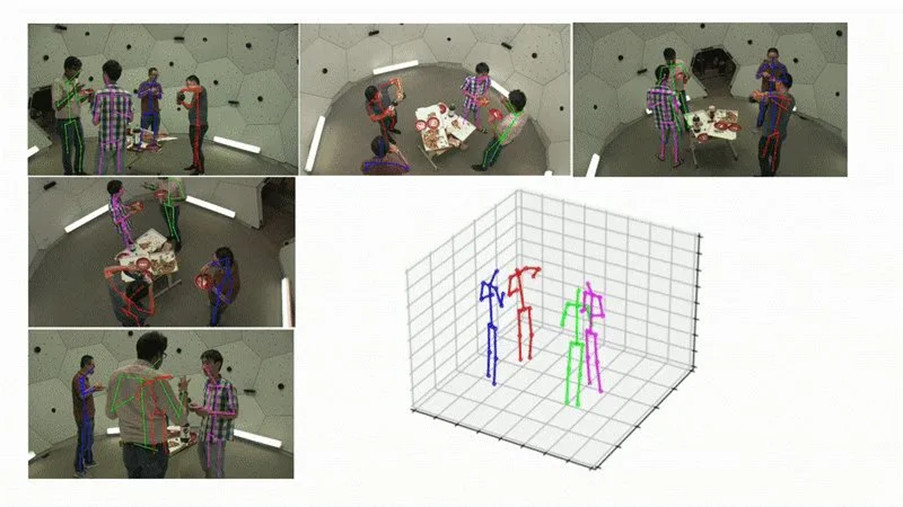

图 1 本文算法的可视化展示

多视角的多人3D姿态估计,指从多个相机(已标定)拍摄的图像中,恢复出该场景的所有的人体骨架。它是视频动作分析和高级人机交互的基础,在运动分析、影视特效等领域具有重要的应用前景。

目前多视角3D人体姿态估计有如下两种主流方案:

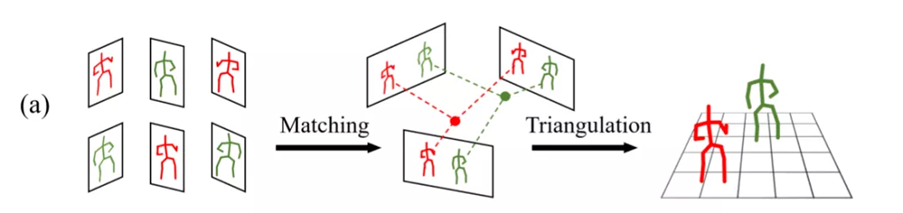

图 2 匹配+三角化重建算法的示意图

(a) 匹配+三角化重建(Triangulation):首先,检测各个视角的 2D 人体骨架;再利用几何关系计算距离,进行多视角人体的匹配;最终,利用多视角的2D坐标和相机参数,计算出3D坐标。

代表方法:MVPose[1]

缺点:(1)方法的精度十分依赖 2D 检测结果。2D 检测的误差会影响匹配的效果,错误的匹配进一步导致异常的重建;2D 的误差也会影响 3D 重建的精度。(2)匹配部分和三角重建部分并不是数据驱动的,没有监督训练和损失反传。

图 3 3D空间体素化算法的示意图

(b) 3D空间体素化:将 3D 空间等距地划分为一个个小网格,通过概率模型或者 3D 卷积神经网络(CNN)检测关键点。

代表方法:VoxelPose[2]

缺点:(1)空间体素化的精度会受到网格大小的制约,会产生量化误差;(2)空间体素化在相同的精度下,计算复杂度随空间大小三次方增长,无法应用于较大场景。

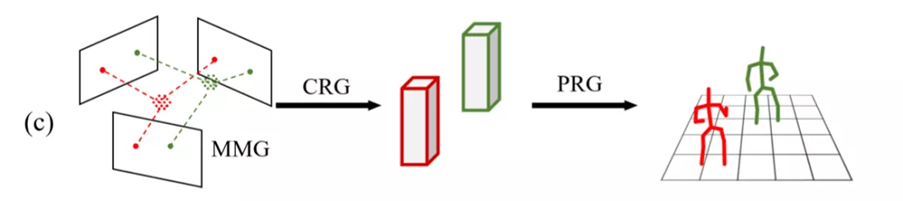

图 4 本文算法的示意图

(c) 本文方法:我们结合两者的优势,提出了一种基于图卷积神经网络的,自顶向下(Top-down)的两阶段算法。我们的整体算法流程,分为两个阶段:3D人体中心点定位+3D人体姿态估计。

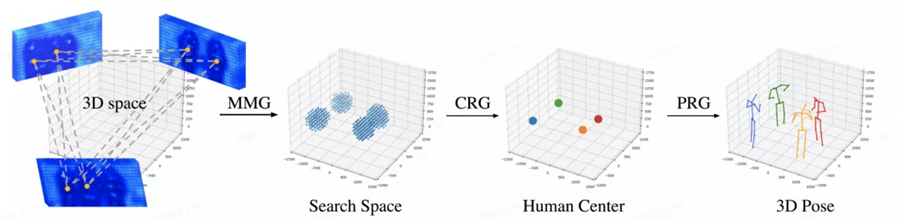

图 5 本文方法的整体框架图

1. 针对3D人体中心点定位,我们采用了proposal-refine "由粗到精"的策略。首先进行”粗筛选”,预测一系列候选中心点位置(MMG);再在候选中心点附近“精细”搜索(CRG),得到精确的人体中心点定位结果。

优点:(1)现有方法在融合多视角的特征时,通常直接级联或池化各个视角的特征向量,忽视了视角之间的相互关系。我们利用图卷积网络,能够有效利用跨视角的特征。(2)我们的"由粗到精"策略,能够有效提升模型的预测精度。(3)搜索空间被限制在了候选中心点附近,与实际的空间大小无关,大大降低了运算复杂度。

2. 针对3D人体姿态估计,我们同样采用"由粗到精"的策略,首先用模型预测初始3D人体姿态,再共同利用人体骨架结构信息和多视角特征,来优化预测的结果(PRG)。

优点:我们采用了"由粗到精"策略。图卷积神经网络PRG,能够直接对人体骨架结构进行建模,利用骨架约束,优化了模型的预测结果。

Part 2: 方法

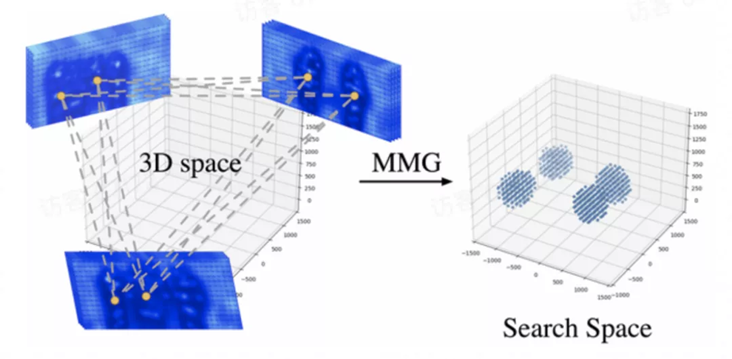

2.1 中心点候选区域生成:Multi-view Matching Graph(MMG)

我们设计了多视角匹配图神经网络(MMG),判断不同视角的两两2D中心点,是否属于同一个人。随后,对于属于同一个人的一对关键点,两两重建出一个3D坐标作为候选中心点。

图 6 MMG模块示意图

建图(Graph Construction):我们利用各个视角检测得到的人体2D中心点,来构造跨视角图模型。图模型的“节点”为 各个视角检测到的2D人体中心点;节点的特征为:2D人体中心点位置的图像特征。图模型的“边”,两两连接不同视角的节点,两个节点对应的2D中心点的极线距离作为边特征。

信息传递(Message Passing):利用GNN来进行相关性特征的学习。我们使用EdgeConv来搭建图卷积神经网络模型,对所构造好的Graph 进行卷积,不断更新节点的特征;通过图的表征,模型同时利用了几何信息(边特征)和图像信息(节点特征),高效的融合多视角特征,匹配精度远高于直接利用极线匹配。

判断边的属性:训练一个边判别器(Edge Discriminator),对每一对中心点(即一个边)进行判别,判断这一对中心点是否属于同一个人。

提出候选点:每一对被判断为同一个人的中心点,通过三角化重建出一个3D候选点。

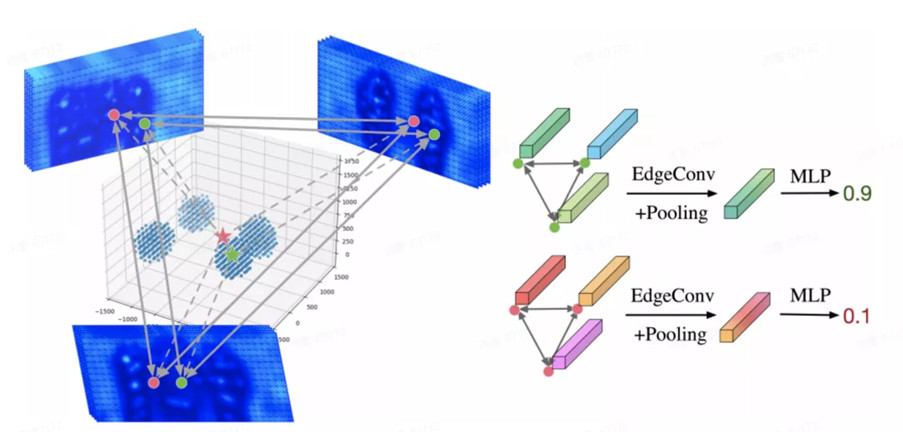

2. 2 中心点坐标优化:Center Refinement Graph(CRG)

有了候选中心点后,我们以候选点为球心的球形范围作为搜索空间,灵活地在候选区域采样。对于每个采样点,将采样点投影到各个视角并在相应位置提取特征。接着利用中心点优化图模型(CRG),通过多个视角节点的连接,实现了高效的多视角特征融合,可以准确地判断采样点是否为人体中心点。

图7 CRG模块示意图

搜索空间:以候选点为球心的球形范围作为搜索空间,所有搜索空间的并集作为总的搜索空间。

采样:我们可以进行适应性的采样,先在搜索空间中等距采样,用中心点图卷积网络检测中心点,在检测到的中心点周围进一步精细采样,以获得更精确的位置。

建图(Graph Construction):对每一个3D 采样点,构建一个图模型。其中,节点和节点特征分别对应 3D采样点投影到各个视角后的2D位置 以及 该位置的图像特征。图中的边,对各个节点进行全连接。

信息传递(Message Passing):利用GCN来进行相关性特征的学习。我们使用EdgeConv来搭建图卷积神经网络模型,利用多层图卷积不断更新节点的特征。

判断图的属性:首先对图中节点进行全局池化,得到图的特征,再训练一个多层感知机MLPs,判断图的属性:判断采样点是否为人体中心,即输出每个采样点为人体中心的置信度。

非极大值抑制 (NMS):得到每个采样点的置信度后,通过NMS操作,获得优化后的人体中心点坐标。

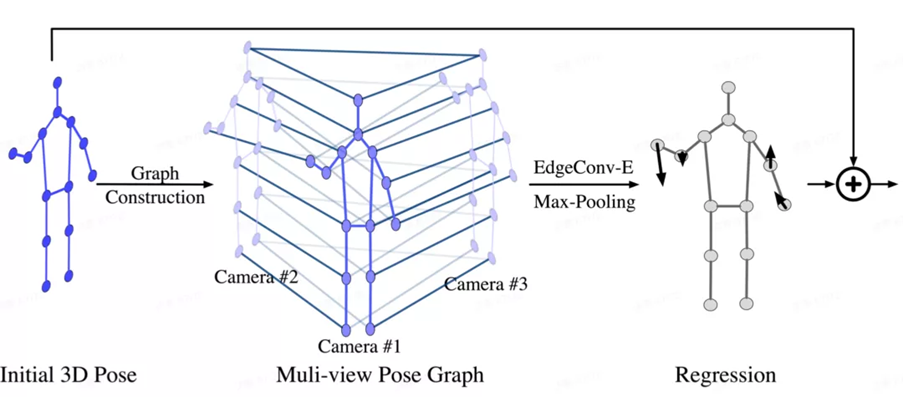

2. 3 人体姿态优化:Pose Regression Graph(PRG)

图8 PRG模块示意图

我们采用"由粗到精"的策略,来估计人体3D姿态。首先,我们采用现有的姿态估计方法[2],得到初始的3D人体姿态(Initial 3D Pose);为了提升人体关键点的预测精度,本文提出了人体姿态回归图模型(Pose Regression Graph, PRG),利用图卷积,高效地融合多视角的特征和人体的拓扑结构信息(头和脖子相连,手和胳膊相连等),回归出每个关键点坐标的修正值。

建图(Graph Construction):首先将初始3D人体姿态,投影到各个相机视角,得到各个视角的2D人体姿态。利用各个视角下的2D人体关键点,构造跨视角姿态图(Multi-view Pose Graph)。

图模型的每个“节点”代表各个视角的每个2D关键点。节点的特征包括:关键点的类别信息,2D关键点位置处的图像特征,以及初始3D人体姿态中对应关键点的置信度。

图模型的“边”代表节点之间的关系,共包括两种类型的边:跨视角且相同类型关键点间的连接边 和 单视角且不同类型关键点间的连接边。

信息传递(Message Passing):利用GCN来进行相关性特征的学习。我们使用EdgeConv来搭建图卷积神经网络模型,对所构造好的Graph 进行卷积,不断更新节点的特征;完成多视角特征的更新和融合后,对相同类型的关键点特征进行最大值池化,得到一副人体骨架。

回归修正值(Regression):使用回归模型,预测出 Nx3 维的偏移向量(其中,N代表关键点个数),代表相对于初始3D人体姿态的修正值。

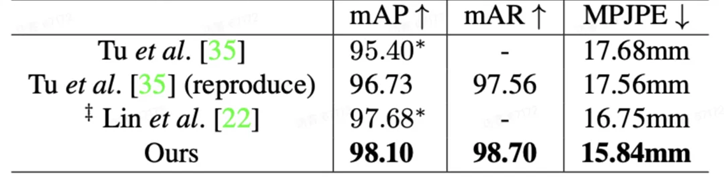

Part 3: 实验结果

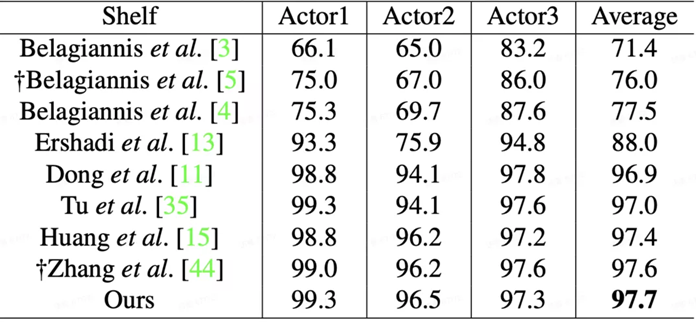

我们在 CMU Panoptic 和 Shelf 两个主流的数据集上做了实验。定量实验表明,我们提出的算法,取得了最优的精度。而且在计算量和耗时方面,我们的方法相比之前的SOTA也有明显优势。

表1 CMU Panoptic 数据集的定量结果对比

表2 Shelf 数据集的定量结果对比

Part 4: 总结与展望

在本文中,我们提出了一套自顶向下的多视角3D人体姿态估计解决方案。我们针对该任务,精心设计了各类“多视角”图卷积神经网络(MMG, CRG, PRG)来提取人体结构性特征。我们在各数据集上的实验,也充分证明了我们算法的有效性。关于对未来的展望,我们将继续研究把算法扩展到时序,实现更高效的多视角人体姿态跟踪。在方法层面,如何更加合理地利用相机的几何信息,设计更高效的图卷积神经网络,是一个重要的改进方向。

Reference:

[1] Dong, J., Jiang, W., Huang, Q., Bao, H., & Zhou, X. (2019). Fast and robust multi-person 3d pose estimation from multiple views. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 7792-7801).

[2] Tu, H., Wang, C., & Zeng, W. (2020). Voxelpose: Towards multi-camera 3d human pose estimation in wild environment. In Computer Vision–ECCV 2020: 16th European Conference, Glasgow, UK, August 23–28, 2020, Proceedings, Part I 16 (pp. 197-212). Springer International Publishing.

返回

返回