- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

ICLR 2024 Spotlight | 自蒸馏激发CLIP模型的检测分割能力

分析CLIP模型的区域表征

我们利用COCO数据集上的区域物体框,让CLIP模型对这些物体框进行分类,计算分类的准确度(mAcc)。

我们分别采用两种方式利用CLIP模型对物体框进行处理:

一种是将整个图像利用CLIP模型提取图像特征,再根据物体框的坐标信息通过局部区域的池化操作(RoIAlign)得到区域密集特征(dense feature),下游的目标检测和图像分割任务需要采用这种方式获得局部物体的感知;

另一种是先将物体框区域从原图裁剪得到的小图像(image crop),再采用CLIP预训练相同的方式,将整个小图像送入CLIP模型提取图像层级的特征。

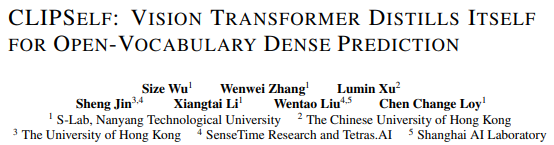

图1. CLIP模型分析

尽管基于ViT的CLIP模型在全图分类上展现出很好的效果(图1(a)),但如图1(b)所示,CLIP ViT的dense feature的效果不佳,不能被用于很好地识别物体。图1(c)中的Kmeans可视化结果也表明ViT的局部特征相对于CNN分散嘈杂。

这是由于ViT不具有CNN的平移等变性和局部性等特点,而预训练只在图像层级对齐了视觉语言的表征,从而缺乏提取良好区域特征的能力。

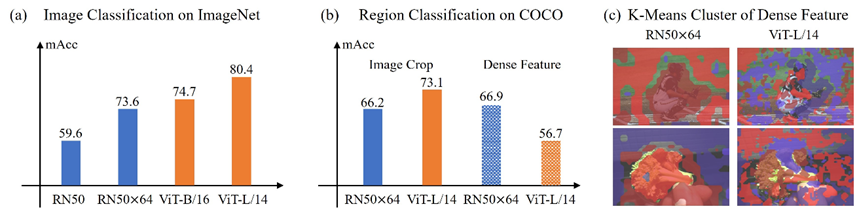

我们进一步对更多主流的CLIP模型的区域密集特征进行分析,在不同的原图尺度上统计物体框的分类精度。

如图2所示,各种CLIP ViT模型的Dense feature对物体框的分类均不如Image crop的图像层级特征。并且,随着图像输入尺寸的增大,CLIP ViT dense feature的能力并没有随之提升,这将不利于下游的目标检测和图像分割任务进行区域识别。

图2. CLIP模型的区域分类精度

方法

为提升CLIP ViT的区域表征,一个自然的做法是构造区域文本对(region-text pairs),直接学习区域表征和文本表征之间的对齐。

然而,人工标注区域文本对数据成本巨大。因此现有的方法(如RegionCLIP)解析图像的caption得到物体名词(object nouns),同时利用预训练的区域生成网络(RPN)生成region proposals吗,再匹配两者获得区域文本对。

由于匹配结果准确度有限,这种区域文本对提供的监督噪声极大。因此,本文提出CLIPSelf以解决上述问题。

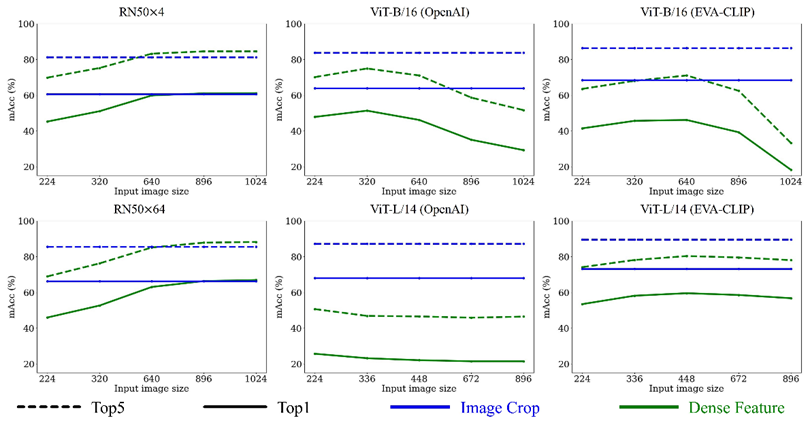

受图1、2中Image Crop的高分类精度启发,我们试图用CLIP高质量的图像特征(teacher)监督其区域特征(student),利用自监督的方式来提升CLIP ViT的密集表征。

CLIPSelf通过最小化CLIP ViT的dense feature(student)和对应的Image crop特征(teacher)的cosine距离,来优化CLIP的局部特征。

如图3所示,CLIPSelf可以不依赖RPN网络提供region proposals,仅将图像均匀划分成MxN个patch即可得到self-distillation所需的图像区域。训练过程中,对每一张图片,我们从{2,3,4,5,6}中随机采样得到M和N。

图3. CLIPSelf的自蒸馏框架

实验结果

3.1 开放词汇目标检测

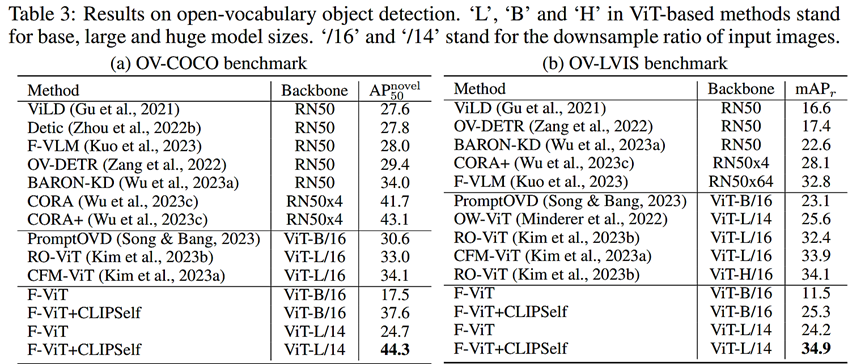

通过将开放词汇目标检测器中的CLIP模型替换为我们CLIPSelf自蒸馏后的版本,我们取得了开放词汇目标检测任务上新的SOTA。

图4. 开放词汇目标检测任务结果

3.2 开放词汇图像分割

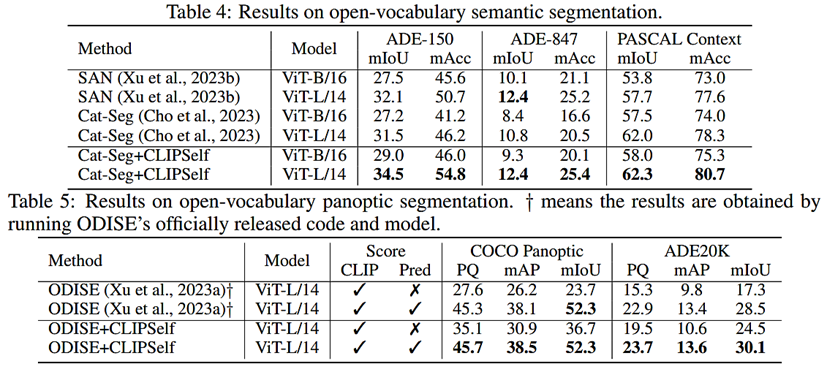

用CLIPSelf优化后的CLIP ViT模型替换原始的模型,可以显著提升现有开放词汇图像分割的效果。

3.3 开放词汇图像分割与构造区域文本对比较

如下表所示,在使用相同的region proposals情况下,self-distillation是比region-text pairs更好的监督来源。

总结

在这篇论文中,我们详细地分析了CLIP模型的局部区域表征能力,发现CLIP ViT区域层级的表征较弱,但是有很强的图像层级表征。

因此,我们提出了一种自蒸馏的方式CLIPSelf,用CLIP ViT强大的图像表征来优化其自身的区域表征。CLIPSelf显著提升了CLIP ViT在开放词汇密集预测(dense prediction)任务中的性能。

返回

返回