- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

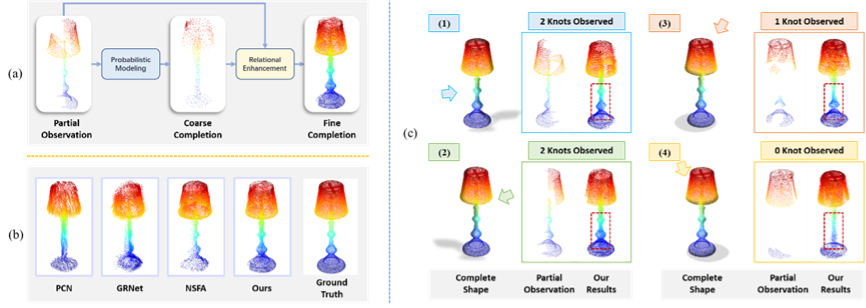

CVPR 2021 Oral | VRCNet:变分关联点云补全网络

Figure 1 VRCNet点云补全方法框架和主要优点总览

Part 1 问题和挑战

点云补全是3D感知中的一个重要并且基础的任务,它旨在基于扫描得到的片面且不完全的点云形状预测和恢复完整的3D模型。现实生活中,由于遮挡等问题造成只能观察到残缺的点云形状,而很多任务很依赖感知到完整的3D形状。比如,抓取机器人需要了解完整的物体形状以稳妥地抓取物体。此外,完整的点云形状还有助于深度学习对3D物体的语义感知和检测。点云补全问题大约可以分为以下三个层次:

1. 点云补全需要能感知并区别不同但类似的点云形状 (辨识)

2. 点云补全需要能从结构关系上分析和理解点云形状 (推断)

3. 点云补全需要对完整点云形状有一定的先验知识 (生成)

3D深度学习的发展使得点云补全也取得了显著的进展。然而,很多现有的方法都只停留在“辨识”层面上,也就是可以从已知的形状中获取与片面观测最相似的形状。可是,新补全的部分和观测到的部分之间缺少关系约束,并且对学习中未见过的新形状缺少推理和生成的能力,甚至难以保留已观测到的形状细节特征。

Part 2 方法介绍

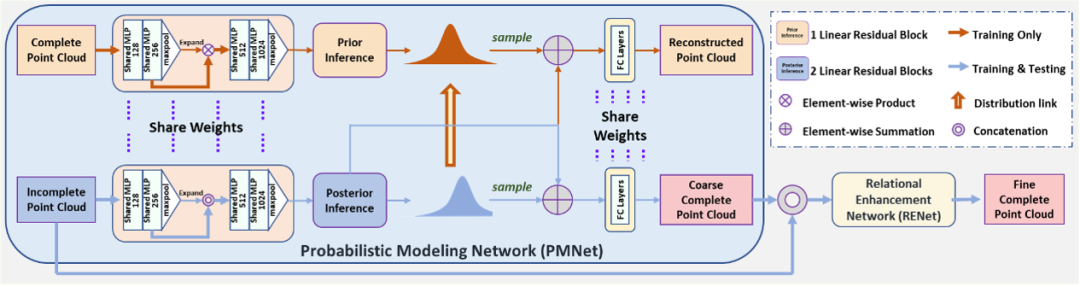

鉴于此,我们提出了一个新颖并且综合性的点云补全网络(VRCNet,如Fig. 2所示)。它由概率模型网络(PMNet)和关系增强网络(RENet)两个子网络级联构成。首先,PMNet基于残缺点云生成一个粗略的点云形状框架,然后再由RENet结合前阶段生成的粗略框架和残缺点云观测,推测具有相关性的结构,以实现最后生成点云细节特征的增强。

Figure 2 VRCNet网络架构:PMNet(浅蓝色)和RENet(浅黄色,细节见Figure 4)

1. 概率模型网络(PMNet)

动机:

由于点云的形状残缺,也导致了其空间分布上的网格缺失,从而影响了全局意义上局部形状细节的生成。为了缓解和避免这个问题,我么提出并设计了PMNet,旨在先从点云的全局特征和分布出发,先生成一个粗略的全局点云框架结构,再以此辅助其形状细节增强。

方法:

PMNet(如Fig. 2浅蓝色框所示) 是一个双通道的网络架构,包含一个重建通道和一个补全通道。重建通道对完整的点云形状做自编码和解码以恢复完整形状,而补全通道通过相似的网络做编码和解码以补全完整形状。两个通道间有多个共享模块。在训练时,重建通道在网络梯度和形状分布两个层面上引导补全通道的学习和收敛。在测试时,重建通道不再使用,网络只输入残缺点云。

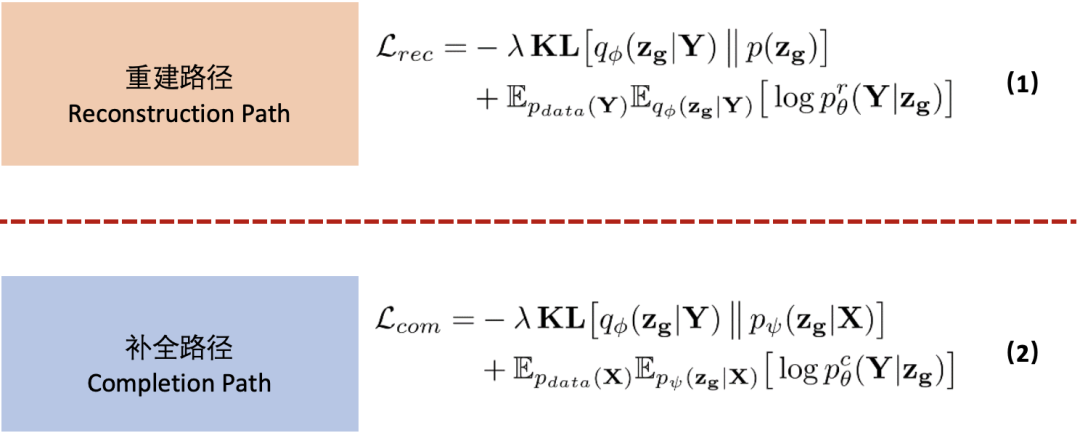

训练时使用到的损失函数如下:

其中表示重建通道的损失函数,而

代表的是补全通道的损失函数。这里

代表对应函数的期望,

是对应数据的真实分布,X 是残缺点云,Y 是完整点云,KL 代表 Kullback–Leibler 散度。重建通道和补全通道的损失函数都包含有两个部分:1)分布之间的散度比较;2)生成的形状与真实数据形状的比较。不同的是,重建通道的编码分布向先验的高斯分布靠近,而补全通道的编码分布向重建通道的编码分布靠近。

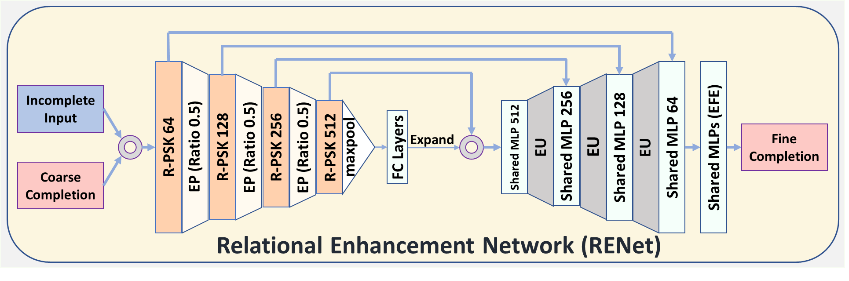

2. 关系增强网络(RENet)

动机:

通过PMNet,我们编码生成了粗略的点云形状框架,但是缺少了很多细节信息。理想的点云补全不仅应当能保留观测到的点云细节信息,还应当根据关联性的结构(比如,人造物体的对称,阵列,以及光滑表面)推测未知的点云的细部特征。于是,我们综合考虑生成的粗略点云形状框架和残缺点云,以进一步增强生成完整点云的细节特征。启发于2D图像中基于自注意力的操作可以有效学习图像特征的关联,我们也致力于探索各种基于自注意力的操作对于点云特征的学习。

方法:

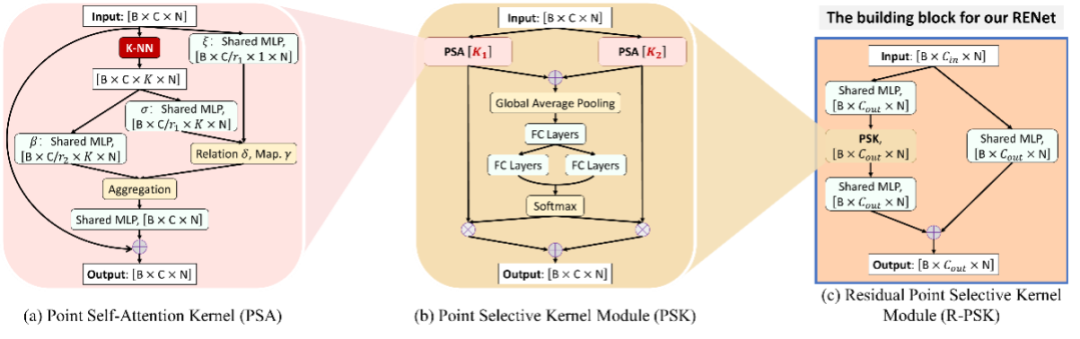

基于提出的多个新颖且强力的点云学习模块,诸如PSA,PSK和R-PSK模块(见Fig. 3),我们构建了 RENet(Fig. 4)网络架构。PSA模块利用点云的自注意力机制,自适应地学习点云局部邻近点之间的关联。PSK模块通过并联多个不同尺度的PSA模块,可以自适应地选取由不同尺度感受野编码得到的特征。此外,通过额外添加的残差链接,我们得到最终的R-PSK模块,而它是RENet的基本运算块。

Figure 3 RENet中使用到的各个基于关系的点云特征学习模块

Figure 3 RENet中使用到的各个基于关系的点云特征学习模块

各个点云模块的具体运算:

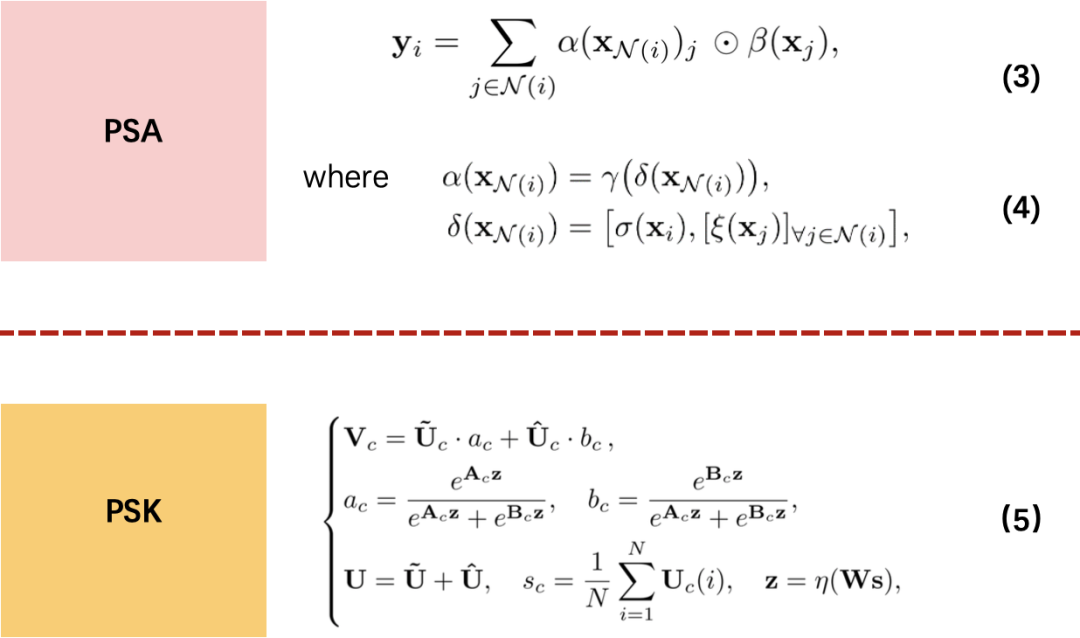

● PSA模块的具体运算展示于公式(3)和公式(4)中。其中,代表点所有搜寻到的 K-NN 临近点

的特征,

,

,

和

都代表了线性变换运算,而

代表了特征向量的链接操作(concatenation)。

● PSK模块的运算可以用公式(5)表述。其中和

是由两个不同尺度的PSA模块编码得到的点云特征;W,A 和 B,是预测的权重矩阵;

是全连接层;V 是最后融合得到的点云特征。

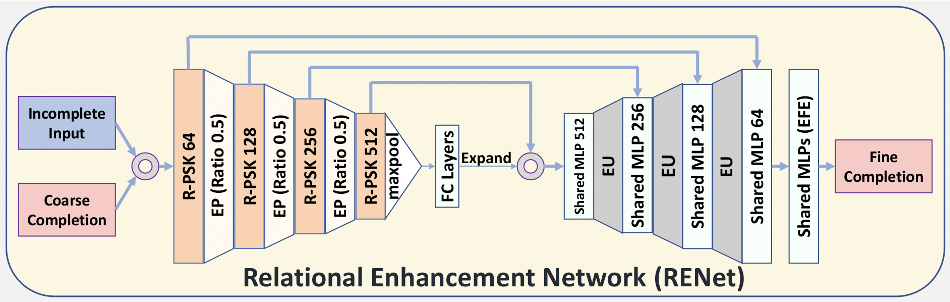

Figure 4 RENet的具体网络架构

基于我们构建的多种模块,我们沿用U-Net[1]的思路搭建起多层级的RENet网络。 此外,RENet还使用了EFE[2]模块以支持多种分辨率的完整点云生成。

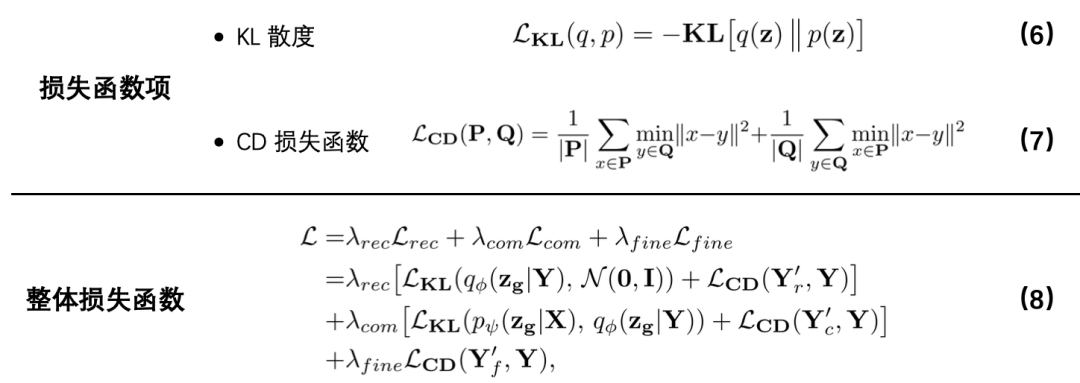

3. 损失函数

损失函数主要有三个部分:重建通道损失函数 ,补全通道损失函数

和关系增强网络的损失函数

。

和

都包含两个损失函数项:公式(6)中的Kullback–Leibler(KL)散度项

和公式(7)中的 Chamfer Distance (CD)损失函数

;

只包含CD损失函数。于是,整体的损失函数定义如公式(8)所示,其中

,

和

是对应的权重参数。

Part 3 MVP数据集

动机:

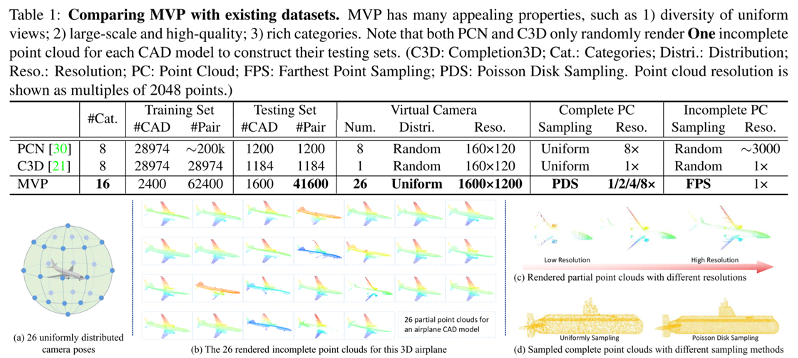

为了建立一个更统一并且综合性的残缺点云数据集,我们生成了MVP数据集。对比之前的残缺点云数据集,比如PCN[3]和C3D[4],MVP有很多吸引人的特性(见Table 1)。

Figure 5 MVP数据集数据生成和质量对比

主要优点:

MVP主要的优点有:1)均匀分布的虚拟相机视角产生了多样化的残缺点云;2)更大数量和更高质量的点云数据;3)丰富的点云种类。由Fig. 5(a)和Fig. 5(b)可以看出,对于同一个完整CAD飞机模型,我们使用了26个均匀分布的虚拟相机,从而采集到丰富且各异的高质量残缺飞机点云。Fig. 5(c)对比了不同分辨率下生成的残缺点云质量,MVP 使用高分辨率也获得了更高质量的残缺点云。不同采样方法生成的完整点云质量对比展示在Fig. 5(d)中。相比较之前方法使用的均匀采样(US),MVP使用的泊松采样(PDS)生成了更高质量的完整点云。

Part 4 实验结果

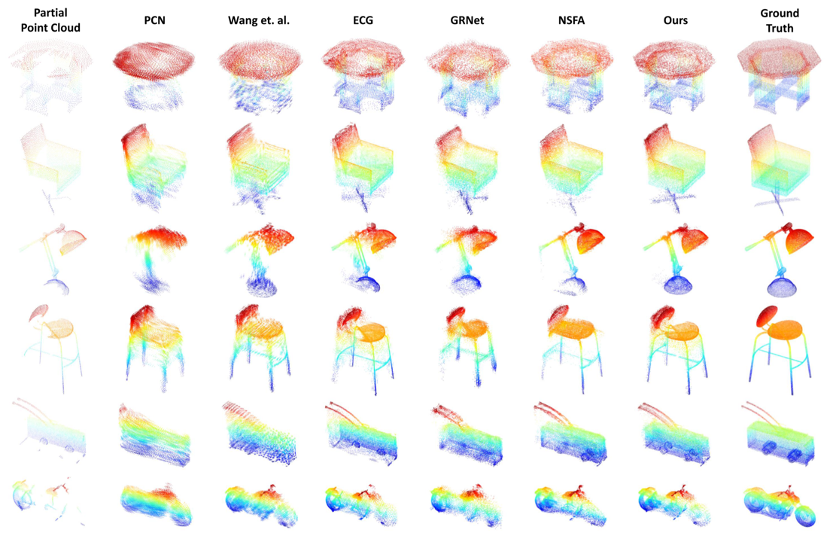

1. 点云补全结果质量对比

Fig. 6是在 MVP 数据集上的不同方法点云补全的效果图对比。VRCNet的结果相比较之前的点云补全方法主要有两方面的优势:1)可以生成更均匀和光滑分布的高质量完整点云;2)可以有效地捕捉到关联性结构并对缺失部分实现合理的生成和补全。

Figure 6 不同方法在MVP数据集上的点云补全结果展示

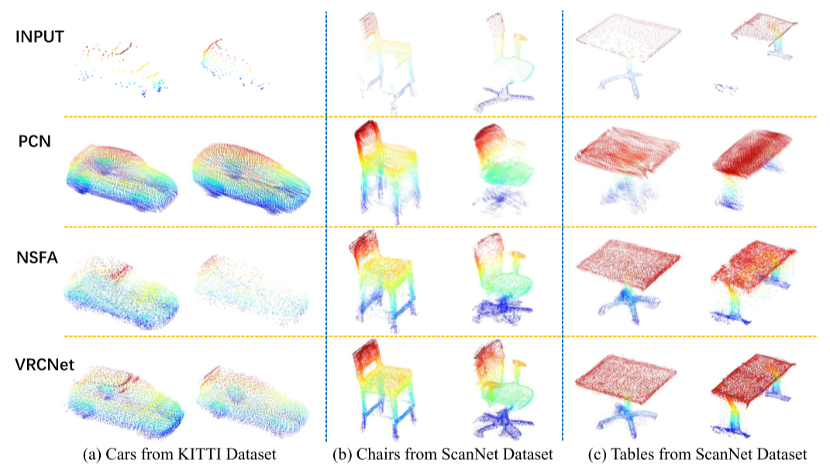

2. 真实点云补全结果展示

我们进一步在现实采集到的残缺点云上检验VRCNet的补全能力。在Fig. 7 中,残缺的汽车点云源于 Kitti数据集(激光雷达采集),而残缺的桌子和椅子点云源于ScanNet数据集(深度相机采集),它们都没有对应的完整的点云。VRCNet通过学习和预测多种对称性,可以较好地生成高质量的完整点云。

Figure 7 在实际采集的残缺点云的补全效果对比

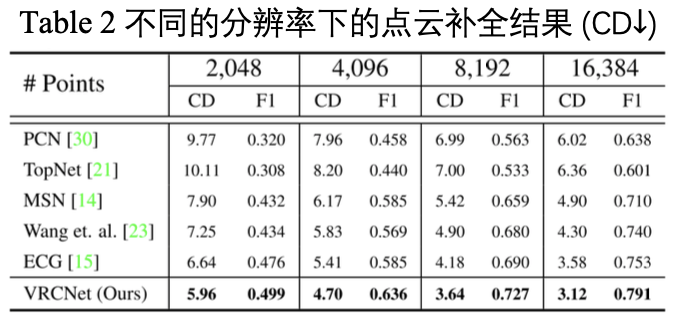

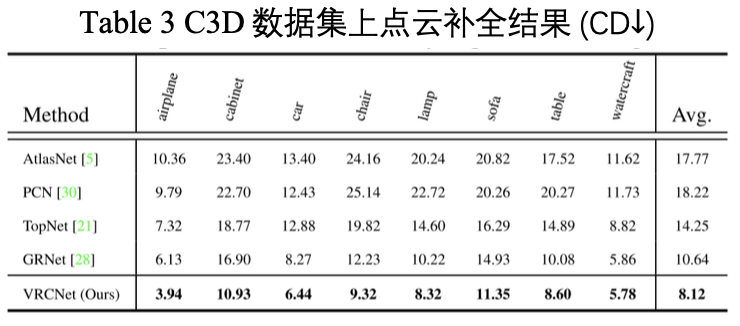

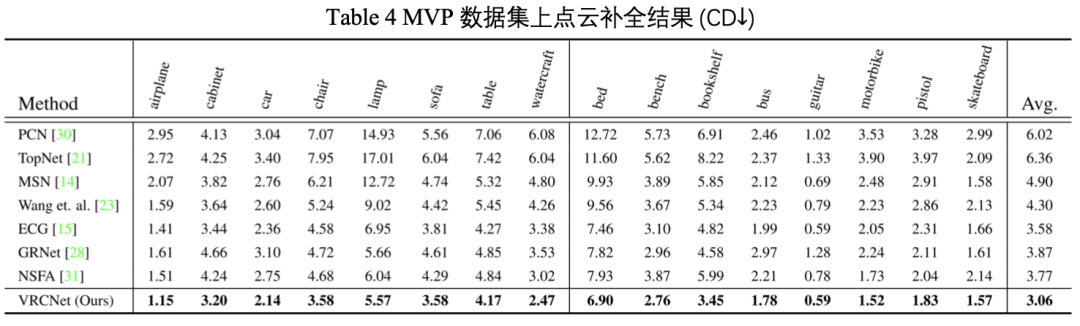

3. 点云补全结果数值对比

与之前提出的方法对比,VRCNet在MVP(见 Table 4)和C3D(见 Table 3)数据集上取得更优的表现,并有着明显的提升。不同的分辨率下的点云补全实验(见 Table 2) 进一步彰显出VRCNet的优越性。

Part 5 结语

在本文中,我们提出了VRCNet,一个变分关联性点云补全网络。VRCNet可以通过学习关联性结构来预测完整点云。此外,我们还提出了多个新颖并且强力的基于自注意力的点云学习模块,如PSA和PSK,它们也可以很便捷地被运用到其他的点云学习任务中。特别地,我们贡献了一个大规模的点云数据集MVP,可以应用于多个点云学习任务,比如残缺点云分类和配准。我们强烈推荐研究人员在后续的点云研究中尝试我们提出的点云学习模块和数据集。

项目主页

https://paul007pl.github.io/projects/VRCNet

论文地址

https://arxiv.org/abs/2104.10154

代码地址

https://github.com/paul007pl/VRCNet

实验室主页

https://www.mmlab-ntu.com/

Reference

[1] Ronneberger, O., Fischer, P., & Brox, T. (2015, October). U-net: Convolutional networks for biomedical image segmentation. In International Conference on Medical image computing and computer-assisted intervention (pp. 234-241). Springer, Cham.

[2] Pan, L. (2020). ECG: Edge-aware Point Cloud Completion with Graph Convolution. IEEE Robotics and Automation Letters, 5(3), 4392-4398.

[3] Yuan, W., Khot, T., Held, D., Mertz, C., & Hebert, M. (2018, September). Pcn: Point completion network. In 2018 International Conference on 3D Vision (3DV) (pp. 728-737). IEEE.

[4] Tchapmi, L. P., Kosaraju, V., Rezatofighi, H., Reid, I., & Savarese, S. (2019). Topnet: Structural point cloud decoder. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 383-392).

返回

返回