- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

ECCV 2022 Oral | 无需标注!将CLIP直接用于分割

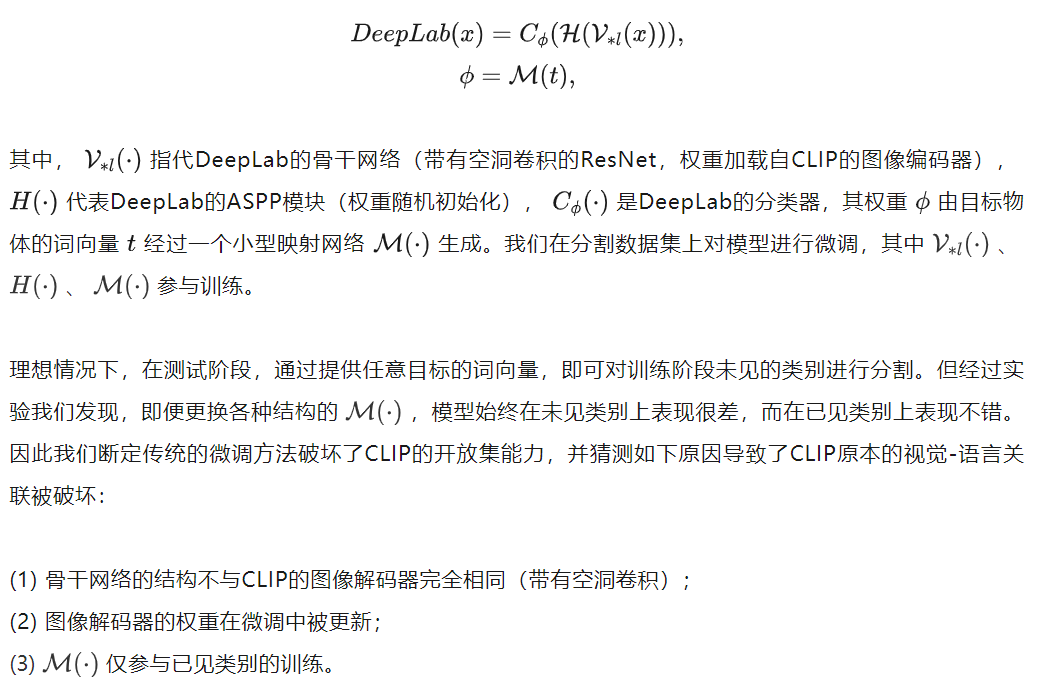

Part 1 传统的微调方法破坏了CLIP的开放集能力

正如导读中所提到的,我们发现CLIP在密集预测任务上存在巨大潜力:同时识别多个目标、理解目标间关系、目标不局限于固定词汇集。因此,我们选定语义分割作为目标任务,对CLIP展开探索。

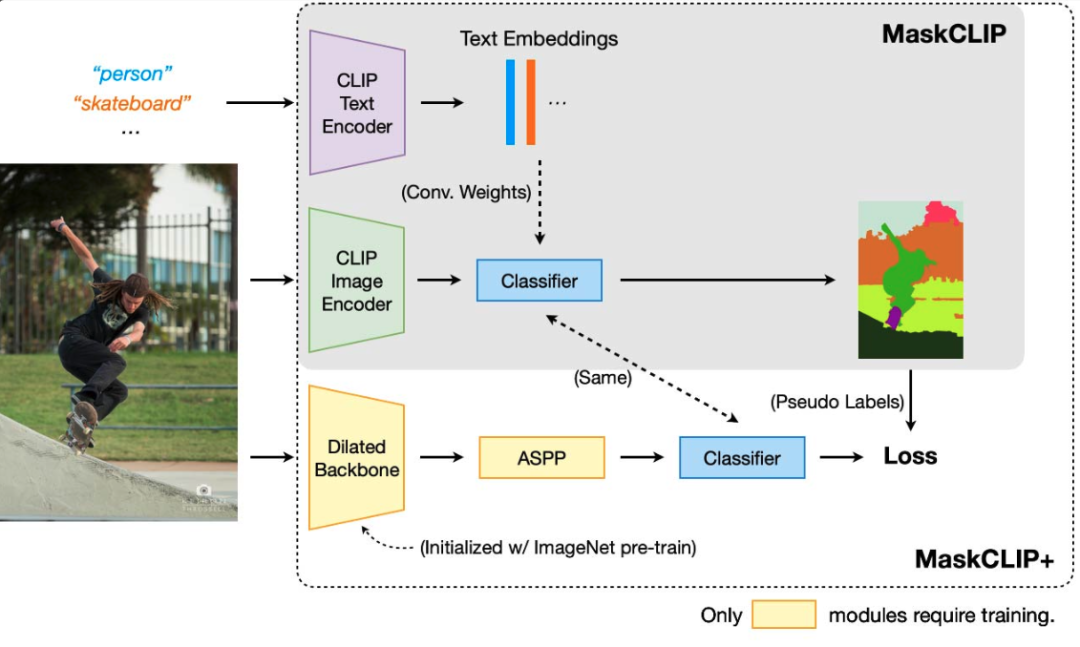

一个自然而简单的想法就是,将CLIP的图像编码器的权重加载到骨干网络,同时将目标物体的单词输入到CLIP的文字编码器中得到词向量,并用这些词向量生成分类器。以DeepLab为例:

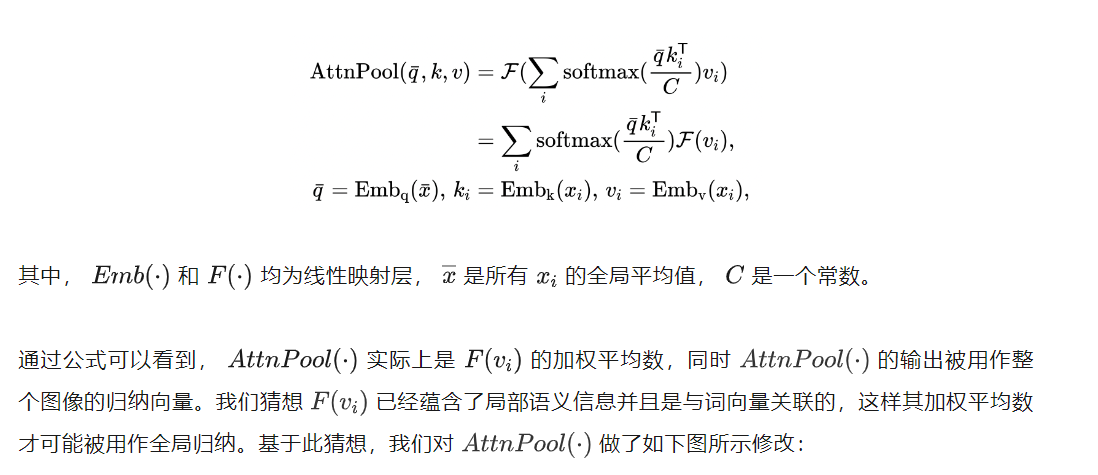

Part 2 无需训练的MaskCLIP

有了前车之鉴,我们转而避免引入新的参数并尽量保持CLIP原有的特征空间不变。让我们重新仔细检视一下CLIP的图像编码器,特别是它独特的全局注意力池化层(类似于Transformer的注意力层):

Part 3 利用MaskCLIP的预测 作为伪标签训练分割模型

虽然MaskCLIP避免了对CLIP进行大幅修改从而保证了视觉-语言关联的完整性且不需要任何训练,但是由于CLIP的图像编码器并不是为语义分割设计的(例如ResNet的32倍降采样),大大限制了MaskCLIP的性能。因此我们进而提出MaskCLIP+,如上图所示,其核心思想为将MaskCLIP的预测用作伪标签,训练更适合分割任务的模型(例如DeepLab)。可以预期的是,MaskCLIP+的性能在训练过程中会超过MaskCLIP,这时再使用MaskCLIP提供监督性能将不会继续提升。因此,一旦观察到这种现象,我们在后续的训练中将使用MaskCLIP+为自己提供伪标签,即自学习。

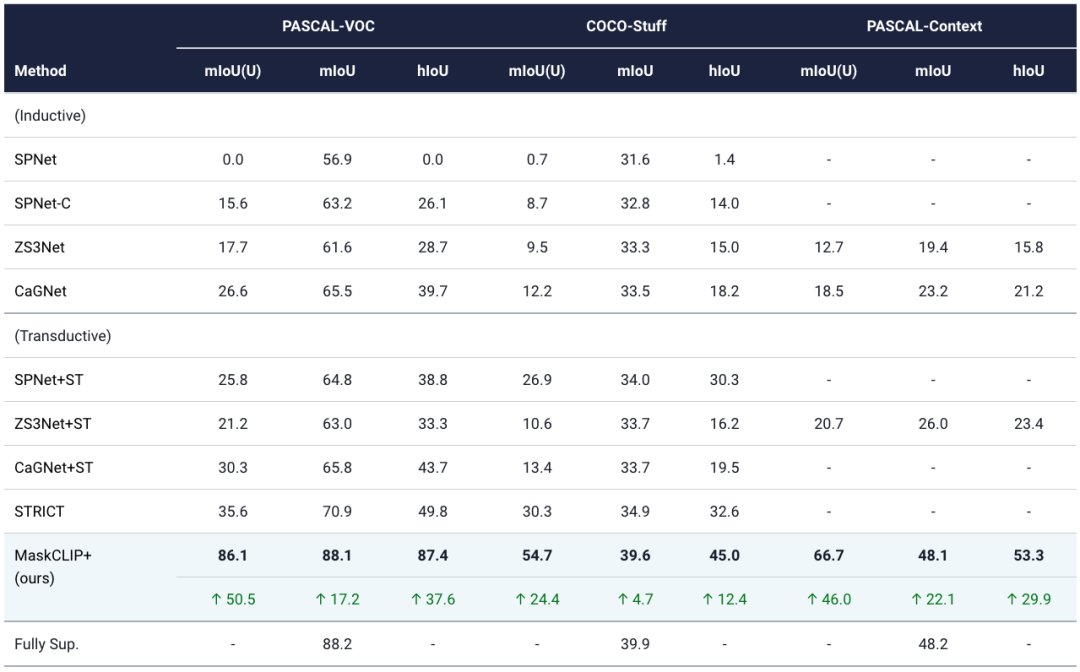

MaskCLIP+可以被自然地用到零样本语义分割任务上:对于提供标签的类别使用标签监督,对于无标签类别,用MaskCLIP提供的伪标签监督。因此,我们提供了与现有SOTA的对比,并发现MaskCLIP+远超现有SOTA,甚至几乎到达全监督模型的水平。

Part 4 实验结果

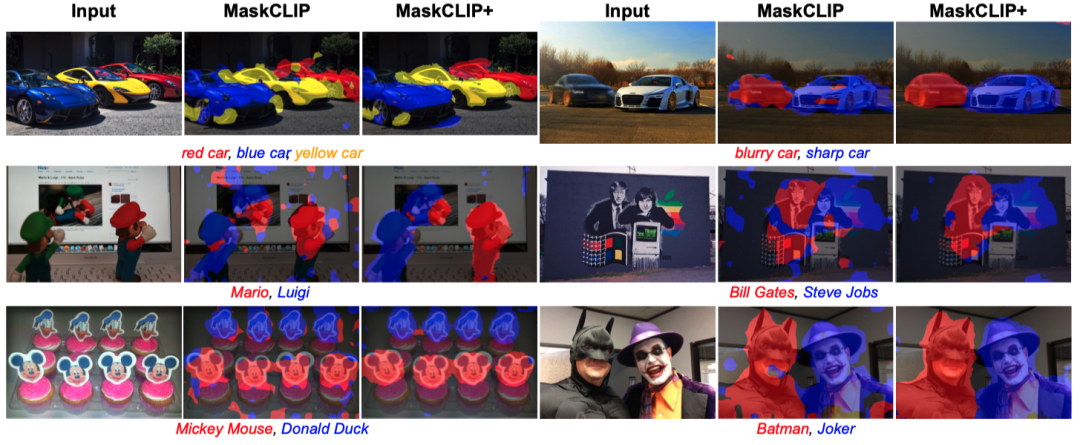

以上测试图片均来自于网络。我们在不使用任何标注的情况下,测试了MaskCLIP(+)对于诸如:颜色、模糊度、卡通人物、汽车品牌等目标的分割性能。

我们在这张表格中将MaskCLIP+与现有的零样本分割SOTA方法在PASCAL VOC、COCO-Stuff、PASCAL Context上进行了对比。ST为Self-Training的缩写。

相关资料

►项目地址:

https://www.mmlab-ntu.com/project/maskclip

►论文链接:

https://arxiv.org/abs/2112.01071

►开源代码:

https://github.com/chongzhou96/MaskCLIP

返回

返回