- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

AAAI 2021 | 视频超分中的可变形对齐解读

在 AAAI 2021,南洋理工大学 S-Lab、香港中文大学-商汤科技联合实验室和中科院深圳先进技术研究院等对视频超分辨率中的可变形对齐作出分析。可变形卷积最初是为适应对象的几何变化而提出的,最近在视频任务中对齐多帧时表现出出色的性能,越来越多地用于视频超分辨率。尽管具有出色的性能,但大家对其对齐的基本机制却没有深入的研究。在这项研究中,本文揭示可变形对齐和光流对齐的共同点,并证明它们的偏移多样性是带来效果差异的关键点。根据探究结果,本文进一步提出了 offset-fidelity loss,该损失可以通过光流来指导偏移的学习。实验表明,offset-fidelity loss 成功地避免了偏移量的过大,并减轻了可变形对齐训练不稳定的问题。

论文名称: Understanding Deformable Alignment in Video Super-Resolution

Part 1 问题和挑战

在视频超分中,如何有效地利用相邻帧的信息是一个关键的问题。通常会采用对齐的方式来融合相邻帧的信息。在早期的工作中[1],通常使用光流把相邻帧的信息对齐到中间帧,再利用对齐后的图片作为输入,重建中间帧。近年的方法[2,3] 引入了可变形卷积作为对齐,从而更高效地利用了相邻帧的信息。

尽管可变形对齐有一定的效果,我们对它却理解甚少。这导致我们无法对可变形对齐进行更深入的研究。另外,在可变卷积参数的训练中会出现不稳定情况,导致无法学习有效的偏移量,进而影响最终结果。

Part 2 可变形对齐与光流对齐之间的关系

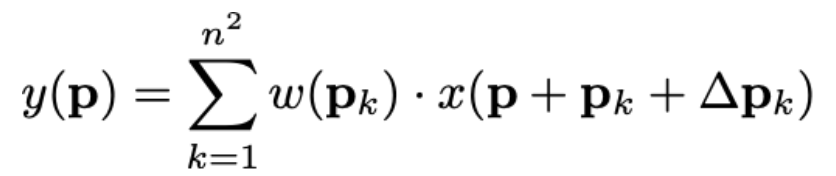

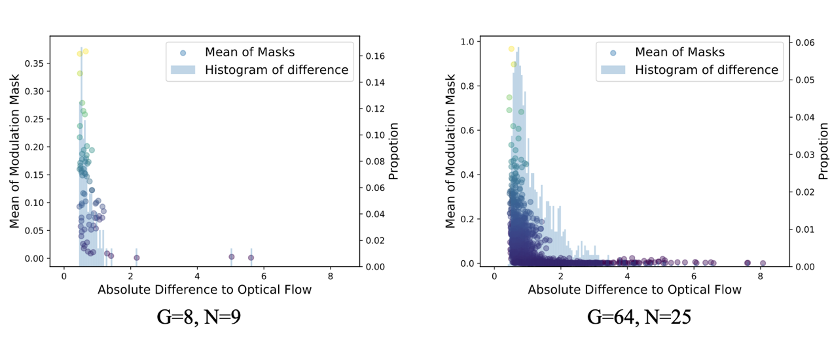

让我们从变形卷积的表述开始:

从这里看来, 变形卷积跟光流没有直接联系,但是对变形卷积分解,可以得出以下关系:

1) 利用![]() 作空间扭曲:

作空间扭曲:

![]()

2) 对于 ![]() 进行卷积:

进行卷积:

从上面的分解可以理解到,可变形对齐与光流对齐类似,也采用了空间扭曲。等效地,我们可以说可变形对齐和光流的区别就是偏移量(offsets)的多少。现在来看一个特例:把 n 设为 1。我们可以看到,可变形对齐就是先对特征进行扭曲,然后进行卷积。

Part 3 偏移量的可视化

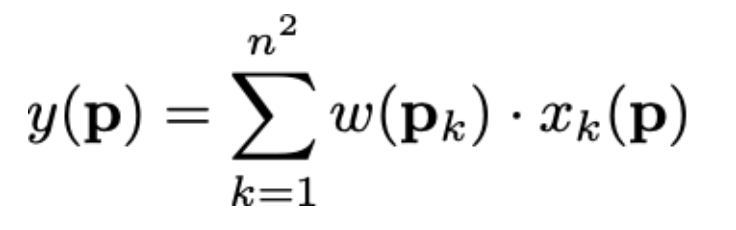

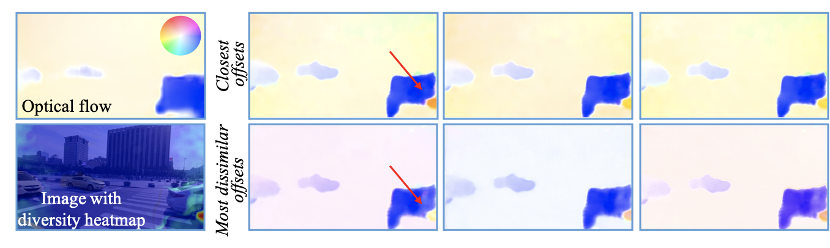

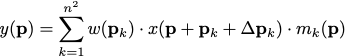

基于上面的分解,我们关心在 n=1 这个特例中,可变形对齐学习到的偏移量跟光流是不是很接近?现在我们就来比较一下。我们使用 EDVR-M 作为 baseline,并把 n 设为 1。然后我们使用 PWC-Net 的光流作为比较,可视化的结果如下:

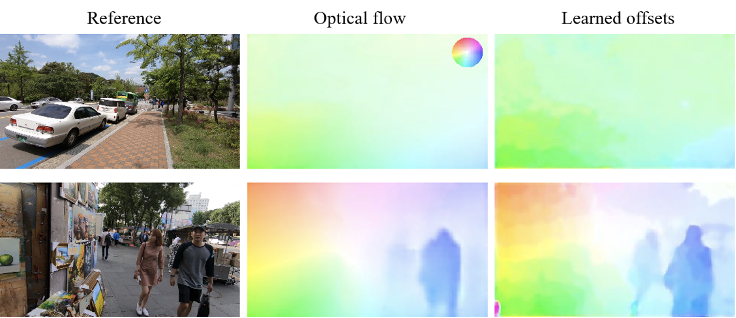

我们看到,EDVR-M 的偏移量确实跟光流非常接近。我们进一步进行定量实验,它们的 L1 距离,发现 80%以上的距离小于 1:

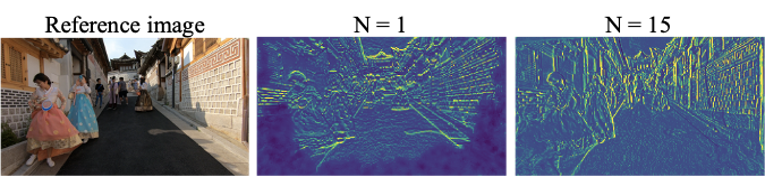

接着的问题很自然就是:那 n > 1 的时候的偏移量是怎样?我们上面的分解使我们可以对偏移量作出跟更深入的分析:我们可以把 n2 换成任意的整数 N,这样我们消除了可变形卷积的约束(即偏移数必须等于卷积核的平方)。现在,我们来看看 N=15 时的偏移量:

我们发现:

(1) 仍然有很大部分的偏移量跟光流接近;

(2) 有部分偏移量跟光流差异非常大,但它们的分别只在方向(颜色),整体形状却是非常接近。这说明物体运动在可变形对齐中仍然是非常重要的。

另外,我们计算偏移量的标准偏差, 发现在物体边界和图像边界(对齐相对困难的地方),偏移量的标准偏差是普遍较大的。这个发现也解释了为什么可变形对齐优于比光流对齐:不同的偏移量是相互补充的。它们允许网络聚合来自不同位置的信息。这在光流不好的区域特别有效。

Part 4 可变形对齐的优点

如上面提及,在物体边界和图像边界,也是比较难对齐的地方,可变形对齐的偏移量的多样性会更大,这对于特微对齐有着很显著的作用,如下图所示:

因为旋转的原因,光流未能找到对应的地方,导致深色(数值等于0)部分的出现。相反地,当 N=15 时,网络可以从特征的其他地方获取信息,对齐后的特征也比较连贯。更好地对齐也为超分效果带来提升:

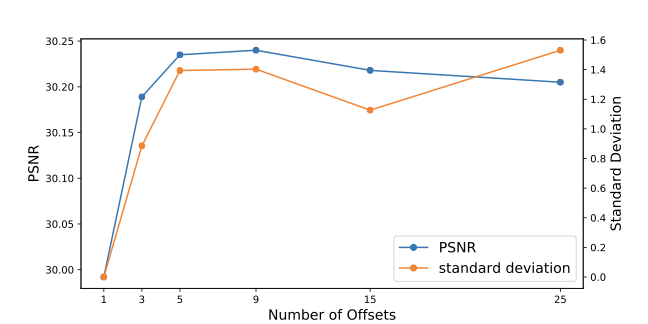

从上图我们可以看出:

(1) 当把偏移量的数量增加,其多样性也会增加;

(2) PSNR 和多样性呈正相关;

(3) 当 N 增加到某个数量时,PSNR 和多样性都会达到饱和。

从以上实验我们可以看到,偏移量的多样性是为可变形对齐带来效果提升的主要原因,但实际上我们需要选择一个适合的数量,否则会为网络带来不必要的计算量。

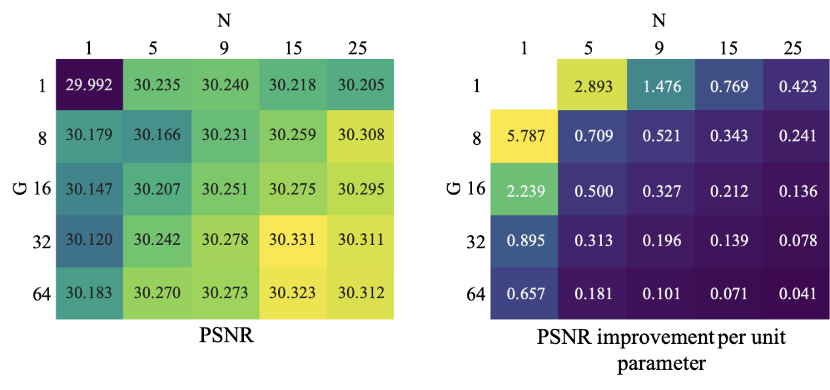

Part 5 变形组的贡献

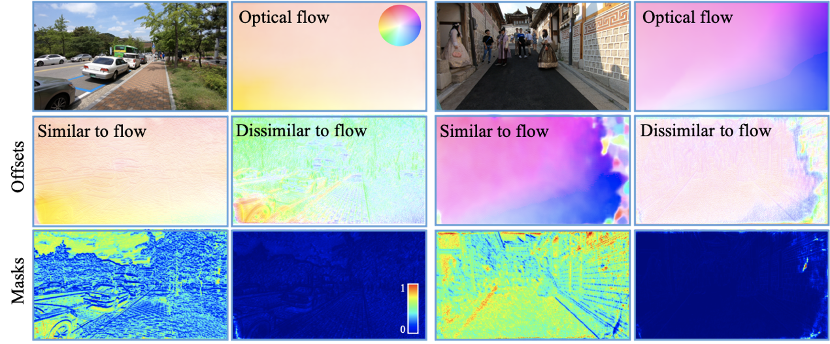

除了增加偏移量的数量,多样性还可以通过增加变形组的数量来实现。假设有 G 个变形组,channel 数是 C。我们首先会把 feature 分成 G 组,每一组学习 N 个偏移量。这样一来,就会学习共 GxN 个偏移量。我们发现,上述的分析也适用于 G:

如右上图显示,无论通过增加 G 或是 N 来提升多样性,都会出现饱和的情况。

Part 6 可变形卷积中的Modulation mask

在调制可变形卷积(又称为DCNv2)[4] 中,学习了额外的 modulation mask 以进一步增强操纵空间支撑区域的能力:

在现有的可变形对齐中,都是使用了 modulation mask。我们接下来看看 modulation mask 的具体作用。

从上图可以得出,mask 对于每个偏移量学习一个权重,较接近光流的偏移量权重较大,相反则较小。

从上图的定量实验也可以看出,跟光流差别较大的,权重会较低。另外,当偏移量的数目增加后,大部份的权重量有着非常小的值,侧面解释了表现饱和的情况。

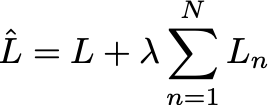

Part 7 Offset-Fidelity Loss

我们可以看到可变形对齐的优点,但训练可变形对齐尤其是在大模型中,是极度不稳定的。在此情况下,偏移量会变得非常大,导致网络无法从相邻帧得到有效信息,变成一个单帧超分网络。

基于我们的分析,光流和偏移量的关系使我们能够利用光流有效地对偏移量作出约束。最简单的方法就是利用 L1 或 L2 loss 限制光流和偏移量的距离。但是这个方法无可避免地减少了偏移量的多样性,而我们的分析证明了这些多样性是非常重要的。所以,我们做了一个简单而有效的操作:只对明显跟光流不同的偏移量作出限制,而和光流接近的不给予限制。这个操作能够使用单位阶跃函数来表示:

![]()

这里的 H 是单位阶跃函数,i 和 j 是空间坐标,x 和 y 是偏移量和光流。L 是原来的损失,例如跟 GT 的 L2 损失。

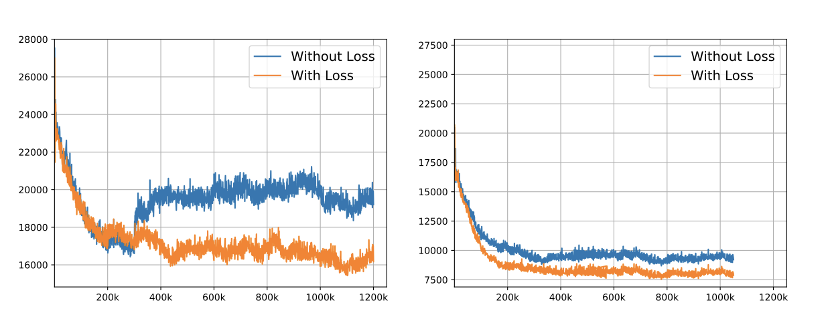

通过这个损失,我们限制偏移量的同时保持多样性,稳定了可变形对齐的训练稳定性。下面的定性和定量比较显示了 offset-fidelity loss 的有效性:

如果没有 offset-fidelity loss,偏移量变得非常大。相反,我们可以看到,加上 loss,偏移量变得可解释,而且同时跟光流有着明显的差别。

从 loss curve 我们可以看到 offset-fidelity loss 能够有效地稳定训练,实现较小的损失值。

Part 8 结语

可变形对齐在视频超分辨率中的成功引起了极大关注。在这项研究中,我们发现了变形对齐和光流对齐之间在概念和行为上的内在联系。对于光流对齐,我们的工作放宽了可变形卷积对偏移数量的约束。它提供了一种更加灵活的方法来增加光流对齐中的偏移量多样性,从而改善了输出质量。至于可变形对齐,我们的研究使我们能够了解其潜在机制,从而有可能激发新的对齐方法。根据我们的分析,我们提出了 offset-fidelity loss,以减轻训练过程中的稳定性问题。

另外, 大家也可以关注一下我们 2020 年在图像和视频超分的新工作~

GLEAN: https://ckkelvinchan.github.io/projects/GLEAN/

BasicVSR: https://ckkelvinchan.github.io/projects/BasicVSR/

论文链接

https://arxiv.org/abs/2009.07265

作者介绍

陈焯杰 (Kelvin C.K. Chan) | 南洋理工大学 S-Lab 和 MMLab 三年级博士生。导师是吕健勤 (Chen Change Loy) 副教授。当前主要研究兴趣为图像和视频还原,主要包括超分辨率和去模糊等。

个人主页:

https://ckkelvinchan.github.io/

References

[1] Xue, Tianfan, et al. "Video enhancement with task-oriented flow." International Journal of Computer Vision 127.8 (2019): 1106-1125.

[2] Tian, Yapeng, et al. "Tdan: Temporally-deformable alignment network for video super-resolution." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020.

[3] Wang, Xintao, et al. "Edvr: Video restoration with enhanced deformable convolutional networks." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. 2019.

[4] Zhu, Xizhou, et al. "Deformable convnets v2: More deformable, better results." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2019.

返回

返回