- 核心技术

- 以原创技术体系为根基,SenseCore商汤AI大装置为核心基座,布局多领域、多方向前沿研究,

快速打通AI在各个垂直场景中的应用,向行业赋能。

EmTech China | 汤晓鸥:人工智能的“中国式十月革命”

1月28日,由《麻省理工科技评论》主办的EmTech China 全球新兴科技峰会在北京举行。来自全球各地的科学家、科技公司领袖及青年科技先锋等出席大会。商汤科技创始人、香港中文大学信息工程系教授汤晓鸥发表了名为《人工智能的中国式文艺复兴》的精彩演讲,以下为演讲全文:

Ladies and Gentlemen, Good morning. Sorry I will conduct my entire talk in Chinese, in 东北 Chinese。今天我讲的题目是人工智能的中国式文艺复兴,这个题目我在上海讲过一次,我这个人不太喜欢重复,于是我又想了一个新的题目,叫人工智能的中国式十月革命。

言归正传,我每次演讲,都是从这张照片开始,有两个原因,第一,这是我儿子;第二,他长得漂亮。今天又多了一个更名正言顺的原因:在座有很多MIT的教授,我儿子再过四、五年就要申请大学了,我想提前让教授们认识一下我儿子,帮助他将来申请。我想我长这样都可以进MIT,他这么帅,应该没问题。虽然他学习成绩很一般,而且不是一般的一般。

再一次言归正传,我想大部分中国人都应该知道这部电影——《战狼》。一下子赚了56亿。这在15、20年前是不可能的;那时候中国的一部电影是不会赚这么多钱的。这有很多原因,其中一个非常重要的原因就是今天我们都愿意花钱去电影院看电影了,而15年前、20年前,很多人会去买盗版的VCD,或者去网上下载一个盗版。如果这样,导演和演员也就没有动力再继续坚持下去了。今天中国电影的成果最重要的推动力就是我们对原创和版权的尊重。

我们现在不是只有一部电影这样成功,比如这部《羞羞的铁拳》羞羞的就赚了22亿,《芳华》是一部文艺片,也能达到14亿的票房,《前任3》的票房是18亿,平均每个前任6亿,《无问西东》是一部非常有情怀的文艺片,也做到了5亿票房。都非常不容易。

所以,对原创的尊重使得中国的原创电影不断往前发展。在三四十年代,全球电影发展起来时,中国电影并不落后,像《马路天使》、《一江春水向东流》一点也不输给好莱坞电影。即使在那个战火连天的年代,中国还能够拍出这些好电影,一个原因可能也是当时没有DVD和互联网来帮助盗版。

再往前,说一下文艺复兴的时候,如果米开朗基罗的这些作品或者任何一个艺术品很快有人进行复制,那么他可能也赚不到什么钱,也可能活不下去。所以,对于原创的尊重也是文艺复兴能真正兴起的一个原因吧。

说到原创,下面我们来讲讲人工智能。一提到人工智能,大家脑海里第一个想到的公司是哪一家呢?是的,我相信大家都猜到了,那一定是商汤科技。请大家不要笑……这个有点不礼貌,我还在台上呢。好吧,目前应该是谷歌,但是总有一天,我相信人工智能这个热潮一定会过去的,等这个热潮过去了以后,商汤一定会成为人工智能最顶级的公司。

那为什么是谷歌?因为谷歌真的把资金投入人工智能发展,2015年的研发经费就是120亿美金。2014年有一家公司叫DeepMind,只有12个员工,没有赚钱,只是在用深度学习玩游戏和下棋,但是谷歌就花了6.6亿美金收购了这家公司。如果是在中国,大家就会花几百万美金把人一个个挖过来,那要便宜得多。但是如果那样做的话,就不会有后来的AlphaGo了。

那么AlphaGo之后大家还能做点什么呢?谷歌又做了AlphaGo 2和AlphaGo Zero,有些公司开始学着AlphaGo下围棋,还有的公司选择打扑克牌,这从某种意义上讲,都是跟着别人的后面做事情。

真正有意义的事情是在AlphaGo之前你做了什么?有没有做什么事情让机器在某项任务上战胜人类。在AlphaGo之前我们做了一件事情,2014年,我们团队从事人脸识别,在全球第一次让机器的人脸识别能力超过了人的眼睛,像AlphaGo一样,在某一个人类定义的单项任务上,机器超越了人类。

超越了人类就过了一条红线,而过了这条红线就可以在工业上进行应用了。但是在真正应用的时候,又发现了很多问题,过了红线还是不够用的,从实验室到大规模产业化还有很长的路要走。2014年,我们用20万人脸来对机器进行训练做到了98.5%的准确率,而人是97.5%;2015年我们用30万人脸进行训练,达到了99.55%的准确率;2016年,我们用6000万人脸训练可以达到了百万分之一的误识率;2017年,我们用20亿人脸训练可以达到一亿分之一的误识率,而这样的误识率才可以真正地应用到各行各业,包括监控、金融、安防、手机等行业。所以,我们和高通签署了全球AI战略合作协议。

那么除了人脸识别,我们现在还做什么?由于时间关系,我从我们做的十几个行业里选出一个来简单介绍一下——视频分析。

下面这个技术是行为检测

这是里约奥运会的跳水比赛直播,大家可以看到过了9分钟也没有看到跳水的内容,要花一大堆时间看一些枯燥的内容介绍。所以,我们用计算机视觉分析的方法,可以从很长的一段视频里把重点内容检测出来,你就可以直接跳过没有意义的部分,直接看这些有趣的、真正的跳水镜头。

下面这个演示是基于内容的视频搜索

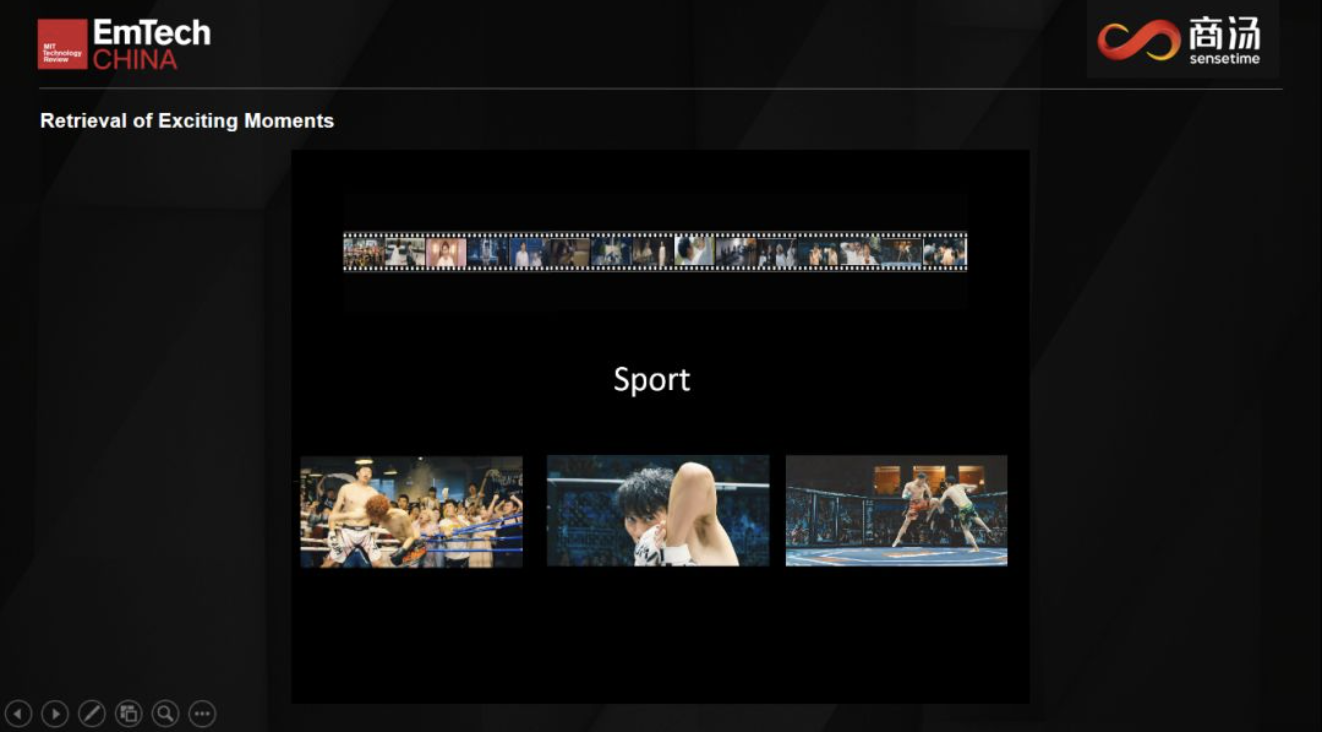

在电影中我们可以把各种各样的片段搜索出来,比如说你想搜索武打动作片段,或者喜剧片段,我们可以直接把它搜索出来,或者你想搜索科幻的,我们可以把科幻的片段搜索出来。

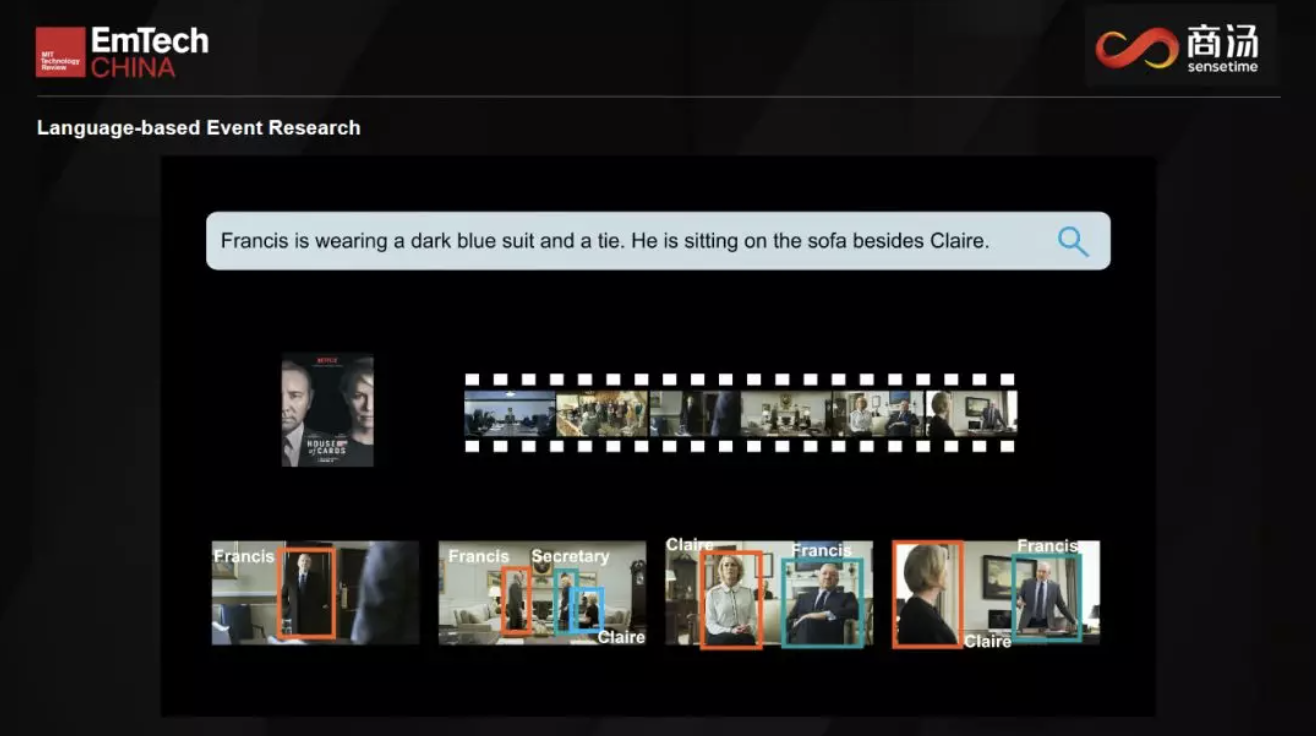

下面这个演示是用自然语言描述来进行场景搜索

我们用自然语言来描述一个电影中的场景,然后它就可以自动根据你的描述把这个电影片段搜索出来,比如,我们要搜House of Cards中的一个片段,“Claire和Francis坐在蓝色沙发上”,大家看到下面这段场景就出来了。

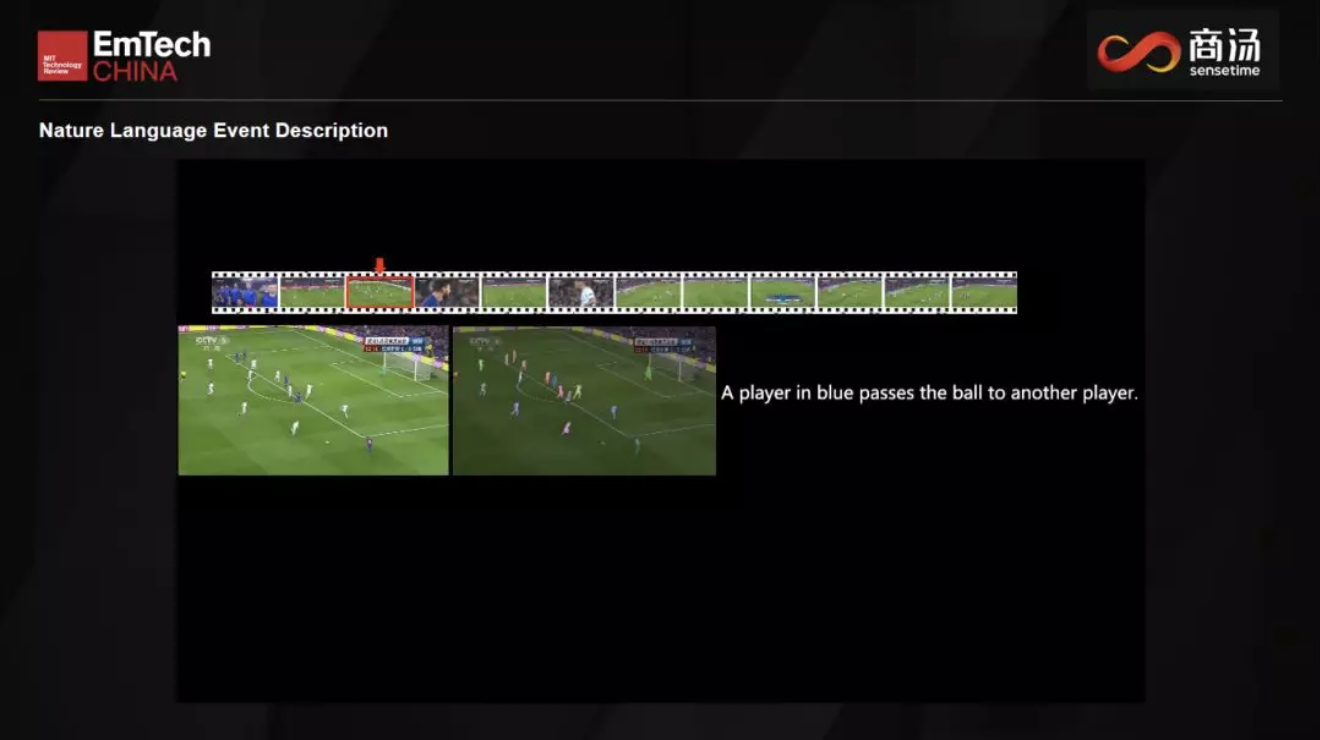

另外我们不但能把视频分析出来,还能理解这个视频,然后用自然语言描述出来。比如下面这些运动视频,机器就可以像解说员一样来描述运动场上发生的事情。

IJCV是我们这个领域的两大顶级杂志之一,作为IJCV的主编,我会在每年的ICCV和CVPR两个计算机视觉顶级会议上,主办IJCV Night晚会,邀请几百位顶级学者参加。去年10月份,我们在威尼斯的Lido酒店举办了这个晚会。

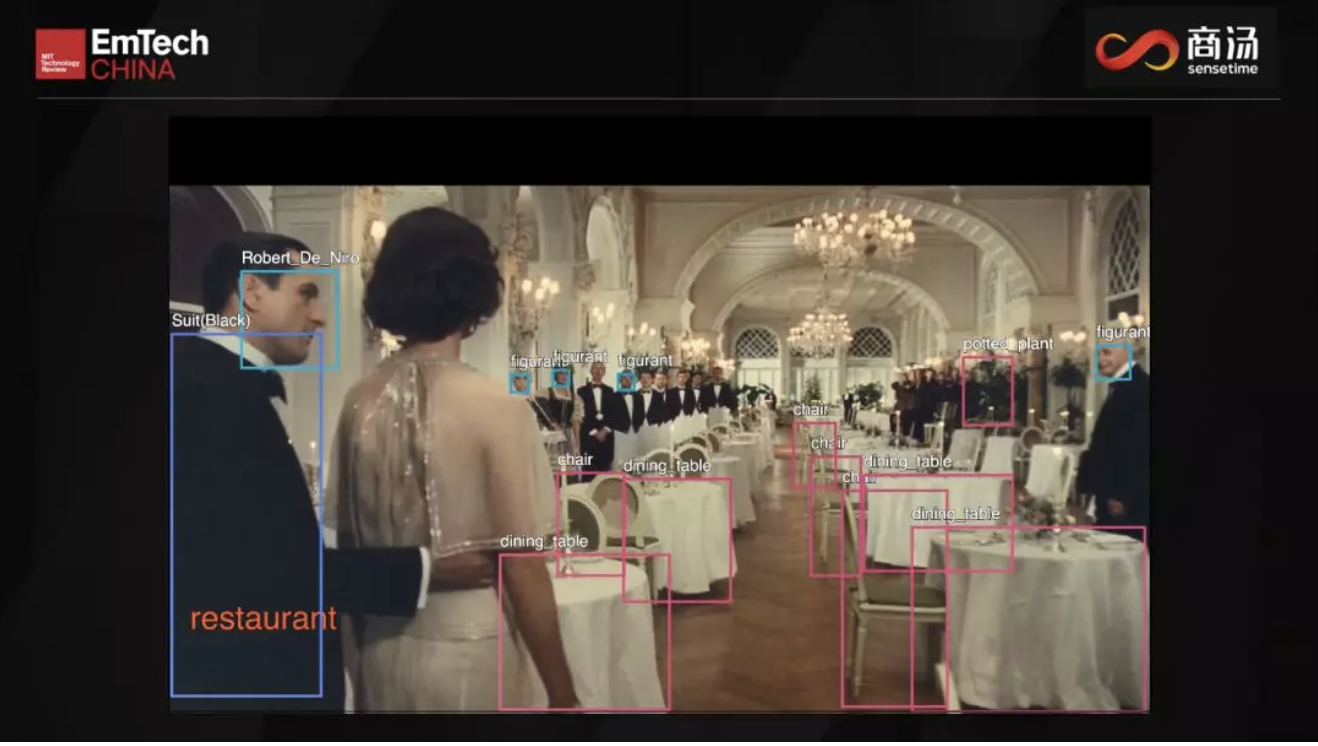

上世纪的一部美国电影《美国往事》就是在这个酒店拍摄的,下面这个演示里我们把电影场景里的所有物体都检测出来,演员是哪一个演员,他穿的是什么衣服,这个场景是在餐厅里,所有的桌子、花、椅子全部能够实时的自动检测出来,这样的技术在以前是非常难的,但是现在我们都可以做到了。

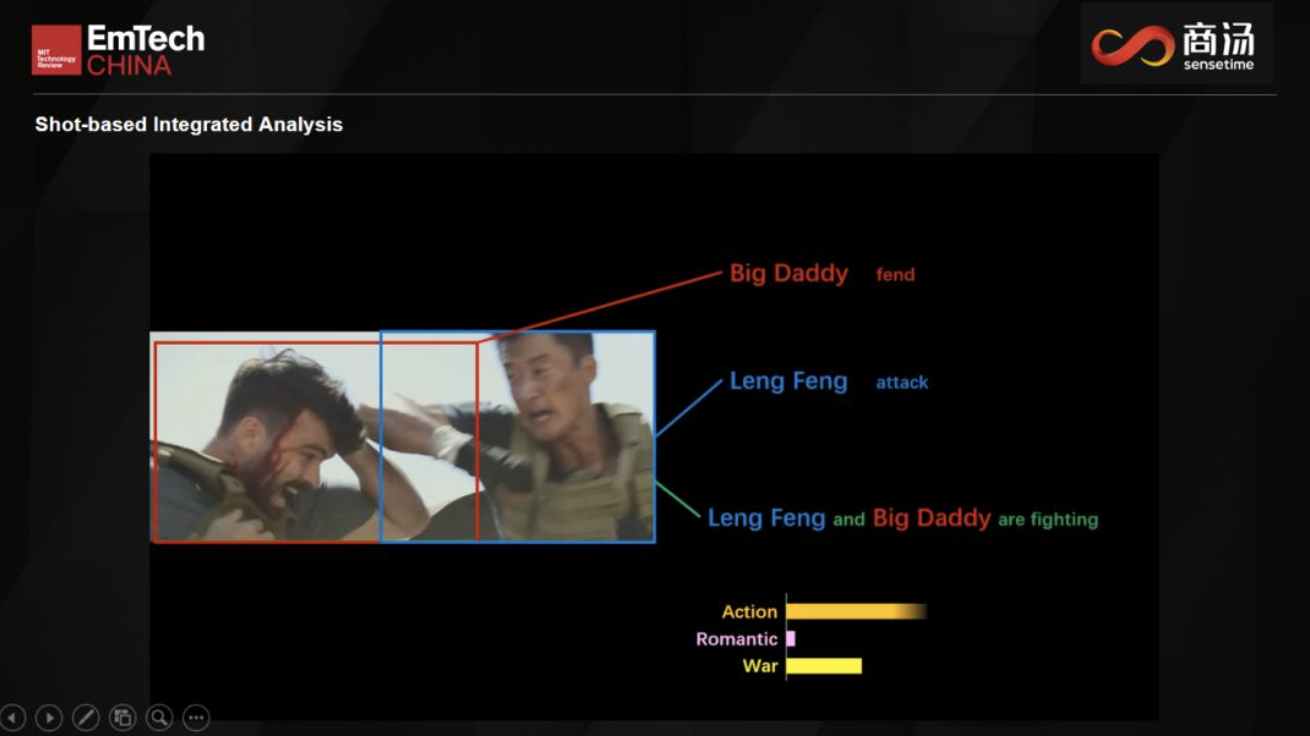

再回头来看我们如何用这些技术来分析前面提到的电影《战狼》和《羞羞的铁拳》,我们通过分析这些演员的动作和他们之间的关系,可以分析出来在不同的场景之下,这两个演员是谁,在做什么,这个片段是什么类的情节。

同时,我们可以识别每一帧情节分类,每一个镜头是打斗场景还是恋爱场景。我们也可以把一个电影最精彩的镜头提取出来,大家可以挑选比如动作的精彩镜头、感情戏的精彩镜头、悲剧的精彩镜头等等。

那么总结起来,我们在做什么呢?我们是在教机器看电影,一开始我们是教机器来识别人脸,Google是在教机器来下围棋,而现在我们来教机器代替人看电影。这个感觉有点怪,我们让机器来做下棋,看电影,玩游戏这些有趣的事情,然后我们人类只负责给机器充充电,维修和保养。

我觉得大家听了这个一定觉得很可笑。实际上所有的任务,都是我们人安排给机器做的,机器是按照我们的指令在做事情,不存在机器控制人类这样的事情,AI的真正目的是帮助人类,帮助我们提高生产效率。

最后给年轻人留下两句话:

第一句,电影一定要自己亲自去看。

第二句,AI这个词在中国拼音翻译过来就是“爱”,所以谈恋爱也要自己亲自去谈,否则你就不止“前任3”了,很有可能“前任4”、“前任5”了。

返回

返回